开发框架

约 65541 字大约 218 分钟

2025-11-16

1.Spring Boot

1.1.全面概述

Spring Boot 是一个构建在 Spring 框架顶部的项目(也就是一个模块)。它提供了一种简便,快捷的方式来设置,配置和运行基于 Web 的简单应用程序。是简化版的 Spring,旨在快速开发中小型的、快速交付、微服务架构的项目,要比 Spring 来得轻量。

它是一个 Spring 模块,提供了 RAD(快速应用程序开发) 功能。它用于创建独立的基于 Spring 的应用程序,因为它需要最少的 Spring 配置,因此可以运行。

基本上 Spring Boot = Spring Framework + Embedded HTTP Server - XML

可以使用 Spring STS IDE, Spring Initializr, IDEA Ultimate 构建一个 Spring Boot 项目。

1.2.基本功能

Web 开发 这是用于

Web应用程序开发的非常适合的子模块。我们可以轻松创建一个独立的HTTP应用程序,该应用程序使用Tomca, Jetty, Undertow等嵌入式服务器。我们可以使用spring-boot-starter-web模块快速启动和运行应用程序。SpringApplication 类 提供了一种方便的方式来引导

Spring应用程序,可以从main方法开始,我们可以仅通过调用静态run()方法来调用应用程序。// Main.java public static void main(String[] args) { SpringApplication.run(ClassName.class, args); }应用程序事件和侦听器

Spring Boot使用事件来处理各种任务。它允许我们创建用于添加侦听器的工厂文件。我们可以使用ApplicationListener 键来引用它。总是在META-INF文件夹中创建工厂文件,例如META-INF/spring.factories。应用管理

Spring Boot提供了为应用程序启用与管理员相关的功能的功能。它用于远程访问和管理应用程序。我们可以使用spring.application.admin.enabled属性在Spring Boot应用程序中启用它。外部配置

Spring Boot允许我们外部化我们的配置,以便我们可以在不同环境中使用同一应用程序。该应用程序使用YAML文件来外部化配置。属性文件

Spring Boot提供了一组丰富的应用程序属性。因此,我们可以在项目的属性文件中使用它。该属性文件用于设置诸如server-port = 8082等属性,它有助于组织应用程序属性。YAML 支持 它提供了一种方便的方法来指定层次结构。它是

JSON的超集(任何JSON文档复制进去都可以通过使用)。SpringApplication类自动支持YAML,它是属性文件的代替方法。类型安全配置 强大的类型安全配置用于管理和验证应用程序的配置。应用程序配置始终是至关重要的任务,应该是类型安全的。我们还可以使用此库提供的注释。

日志

Spring Boot对所有内部记录都使用通用记录。默认情况下管理日志记录依赖项。如果不需要自定义,我们不应更改日志记录依赖项。安全性

Spring Boot应用程序是spring的Web应用程序。因此,默认情况下,通过所有HTTP端点上的基本身份验证,它是安全的。可以使用一组丰富的端点来开发安全的Spring Boot应用程序。

1.3.快速使用

1.3.1.使用终端命令搭建项目

注意

注意:不过我的习惯是先体验原生的生成器来配置,然后再来体验 IDE 这些便携工具,这种知晓一切的感觉很舒服。因此本教程对于没有下载 IDEA 的新手来说是可以无痛运行的(当然,您需要安装 Java),因此本教程使用在 Linux 环境下使用,请您最好在 Linux 操作系统中运行。

1.3.1.1.构建项目

下面我们将依据 官方快速入门文档 尝试构建一个 Spring Boot 项目。

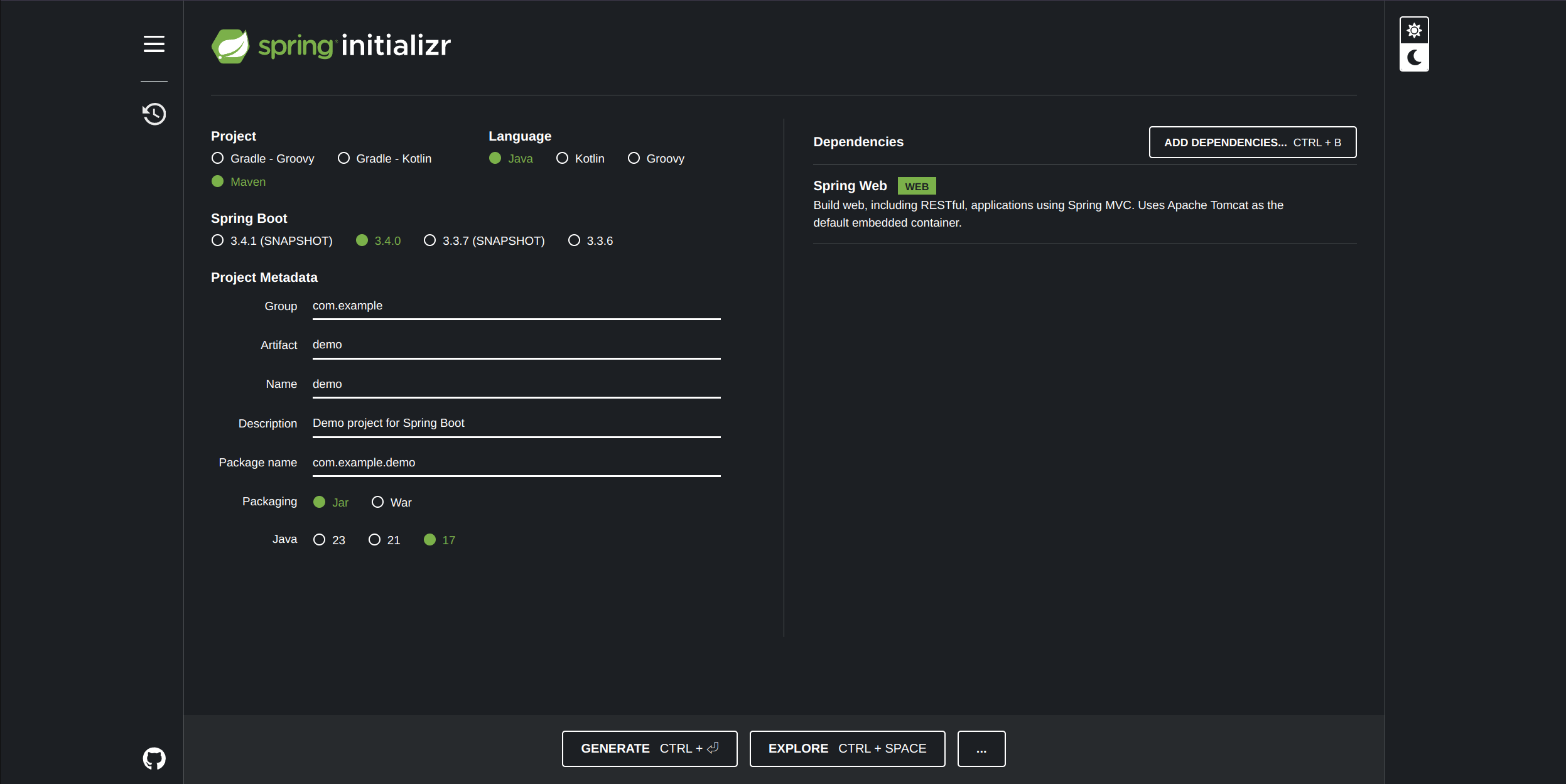

- 我们将打开浏览器访问 spring initializr 来快速生成一个

Spring Boot项目开发脚手架 - 项目构建工具选择

Maven - 项目语言选择

Java,这也是主要的工业开发语言 - 选择官方推荐的

Spring Boot 3.4.0版本 - 创建

web项目,在Dependencies(依赖项)对话框中,搜索并添加Spring Web依赖项 - 填写元数据 项目公司域名组、项目包名、项目名、项目描述、项目包名

- 选择项目包类型

- 选择语言版本,这里我选择

Java 17,请注意在您的Linux里使用sudo apt install -y openjdk-17-jdk下载Java 17,避免版本不匹配 - 点击 “生成” 按钮,下载

zip文件,然后将其解压缩到计算机上的文件夹中 - 此时浏览器可以从远端下载到您配置好的

Spring Boot项目脚手架代码

重要

补充:如果您需要更换 Spring Boot 版本,则可以直接在项目生成后的 pom 中修改,不过其实您也可以考虑使用别的初始化模板网站,只是官方的初始化模板网站不再支持这种行为而已。例如访问 https://start.aliyun.com/ 即可得到其他更多的 Spring Boot 版本。

1.3.1.2.目录结构

下面就是一个 Spring Boot 生成的目录结构,相关注释我都写在里面了。

# 查看项目目录结构

$ tree demo

demo

├── HELP.md # 项目相关的帮助文档或使用指南

├── mvnw # 在 Linux 或 macOS 上执行的脚本(如果开发环境中没有安装 Maven, mvnw 可以自动下载并使用指定版本的 Maven)

├── mvnw.cmd # 在 Windows 上执行的脚本

├── pom.xml

└── src # 项目源代码

├── main # 主要代码

│ ├── java

│ │ └── com

│ │ └── example

│ │ └── demo

│ │ └── DemoApplication.java # 程序入口文件

│ └── resources

│ ├── application.properties

│ ├── static

│ └── templates

└── test # 测试代码

└── java

└── com

└── example

└── demo

└── DemoApplicationTests.java # 测试程序入口文件

15 directories, 7 files重要

补充:Maven 有什么用呢?主要是 Java 项目的构建工具,类似 C++ 中的 CMake 工具,但是使用起来会稍微简单一些,可以简化和自动化软件的构建、测试、部署、依赖流程。

1.3.1.3.代码实践

我们将依据 官方快速入门文档 在 Spring Boot 项目运行打印出 Hello World。

在 src/main/java/com/example/demo 文件夹中找到 DemoApplication.java 文件,初始内容如下,我给出了部分注释。

// DemoApplication.java

package com.example.demo; // 反域名包名, 声明当前类所在的包

import org.springframework.boot.SpringApplication;

import org.springframework.boot.autoconfigure.SpringBootApplication;

/* @SpringBootApplication 一个复合注解 */

@SpringBootApplication

public class DemoApplication { // 入口类

public static void main(String[] args) { // 入口方法

SpringApplication.run(DemoApplication.class, args); // 启动 Spring Boot

}

}接下来的编码很简单,我们只需要让 Spring Boot 项目中添加我们自己的代码,然后运行起来就可以了。

// DemoApplication.java

package com.example.demo;

// 这里的 import 引入了关于 Spring Boot 和 Spring Web 必要的类和注解

import org.springframework.boot.SpringApplication;

import org.springframework.boot.autoconfigure.SpringBootApplication;

import org.springframework.web.bind.annotation.GetMapping;

import org.springframework.web.bind.annotation.RequestParam;

import org.springframework.web.bind.annotation.RestController;

@SpringBootApplication

@RestController // 控制器注解, 表示该类是一个 RESTful 控制器, 返回的是对象本身, 并自动将其序列化成 JSON 格式返回给客户端, 而不是返回视图

public class DemoApplication {

public static void main(String[] args) {

SpringApplication.run(DemoApplication.class, args);

}

@GetMapping("/hello") // 这是一个 Spring Web 注解, 用于将 HTTP GET 请求映射到 hello() 上, 路径为 '/hello'

public String hello(@RequestParam(value = "name", defaultValue = "World") String name) {

return String.format("Hello %s!", name);

}

}总的来说:

- 使用

@GetMapping注释可确保将对/hello的HTTP GET请求映射到hello() - 使用

@RequestParam将查询字符串参数name的值绑定到hello()的name参数中,如果请求中不存在name参数,则使用defaultValue中定义的值 - 使用

@GetMapping可以映射HTTP GET方法到您自己的方法上 - 使用

@RestController并且默认存在序列库Jackson的情况下,Spring Boot会根据一个对象的成员自动序列化为一个JSON数据(不过有些是直接返回字符串,例如字符串对象),后面会介绍自定义序列化数据的操作

重要

补充:补充一些基础知识,如果您缺少这些知识,请一定要进行补全。

- RESTful 控制器:

REST(Representational State Transfer)是一种基于HTTP协议的通信方式,主要用于客户端和服务器之间的通信,通常用于提供 Web API。RESTful API遵循一系列的设计原则,通常会使用HTTP动作(如GET、POST、PUT、DELETE等)来进行数据的操作。控制器注解可以让类中经过映射的方法接收HTTP请求并返回响应。 - 返回对象本身,而非视图:传统的

Spring MVC控制器(使用@Controller注解)通常会返回一个视图名(例如JSP标签或Thymeleaf模板),Spring会将数据与视图模板结合并返回给客户端。不过这种开发方式已经有些过时,是不可能完全做到前后端分离开发的,和早期的C++ Web开发是差不多的,存在很多开发困难。但是,RESTful 控制器 的作用是提供一个 Web API,可以直接返回 数据(如JSON或XML),而不是视图。在@RestController中,返回的对象会被自动序列化为JSON格式(默认使用 Jackson 序列化库来将 Java 对象转换成 JSON 格式),直接作为HTTP响应返回给客户端。

该怎么在命令行中启动我们的 Spring Boot 项目就像运行一个普通 Java 程序一样呢?首先需要使用 mvnw 安装需要的依赖(我们得到的仅仅是带有脚本的脚手架和一些基本的文件,不包含 Spring Boot 的源代码),然后才能让我们的 Spring Boot 项目生成 Java 的字节码,进而

# 命令行原生启动 Spring Boot

# 进入项目

$ cd demo

$ pwd

/home/ljp/test/java/demo

# 安装依赖

$ ./mvnw clean install # 哪怕是有稳定的网络都需要安装很久, 请耐心等待...

# 运行项目

$ ./mvnw spring-boot:run

# 打包项目

# $ ./mvnw package # 会在 target/ 中打包好 jar 包

# 前台部署

# java -jar target/demo-0.0.1-SNAPSHOT.jar在本地机器的浏览器 URL 中直接访问 http://127.0.0.1:8080/hello(或者携带参数的 http://127.0.0.1:8080/hello?name=limou),就可以在浏览器页面中渲染出 Hello World!(Hello limou!),其中直接运行项目适合进行开发测试,打包适合直接部署到服务器上运行。

重要

补充:为什么返回的字符串后不会被渲染为 JSON 字符串?

Spring框架如果检测到返回值是一个字符串,会将它直接作为HTTP响应体(text/plain或text/html)。- 如果返回的内容是一个复杂对象,例如

Map或自定义类实例,Spring才会自动将其序列化为JSON格式。

重要

补充:当然仅仅是这样是不够的,为什么,因为这样仅仅是写好了一个后端接口而已,cpp-http 可以做到、python-flask、python-django 可以做到、node.js-koa.js 可以做到,为什么偏偏工业偏爱使用 java-spring boot 呢?因此您需要了解更多关于 Spring Boot 的配置内容。

1.3.2.使用集成环境搭建项目

根据常见的服务器开发,这里给出一份关于 Spring Boot 的总文档,旨在让您只看一遍就知道如何编写一个完整的 Web 服务器。

下面是您可能需要的资料:

这里将先根据 构建 RESTful Web 服务 和 使用 RESTful Web 服务 这两份官方文档、其他官方文档、我个人的见解来讲述如何完整编写 RESTful Web 规范的 Web 服务器。

1.3.2.1.编码目标

- 我们将实现一个

Web服务器 - 构建常见的

HTTP请求 - 需要自定义返回的

JSON格式

1.3.2.2.创建项目

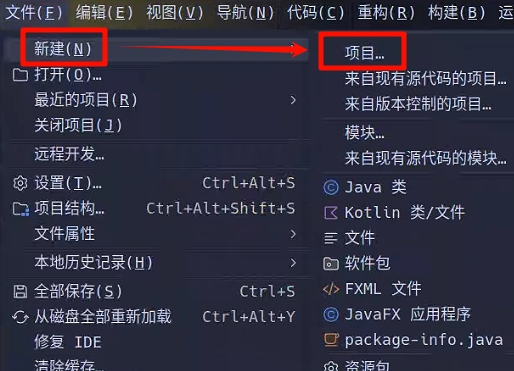

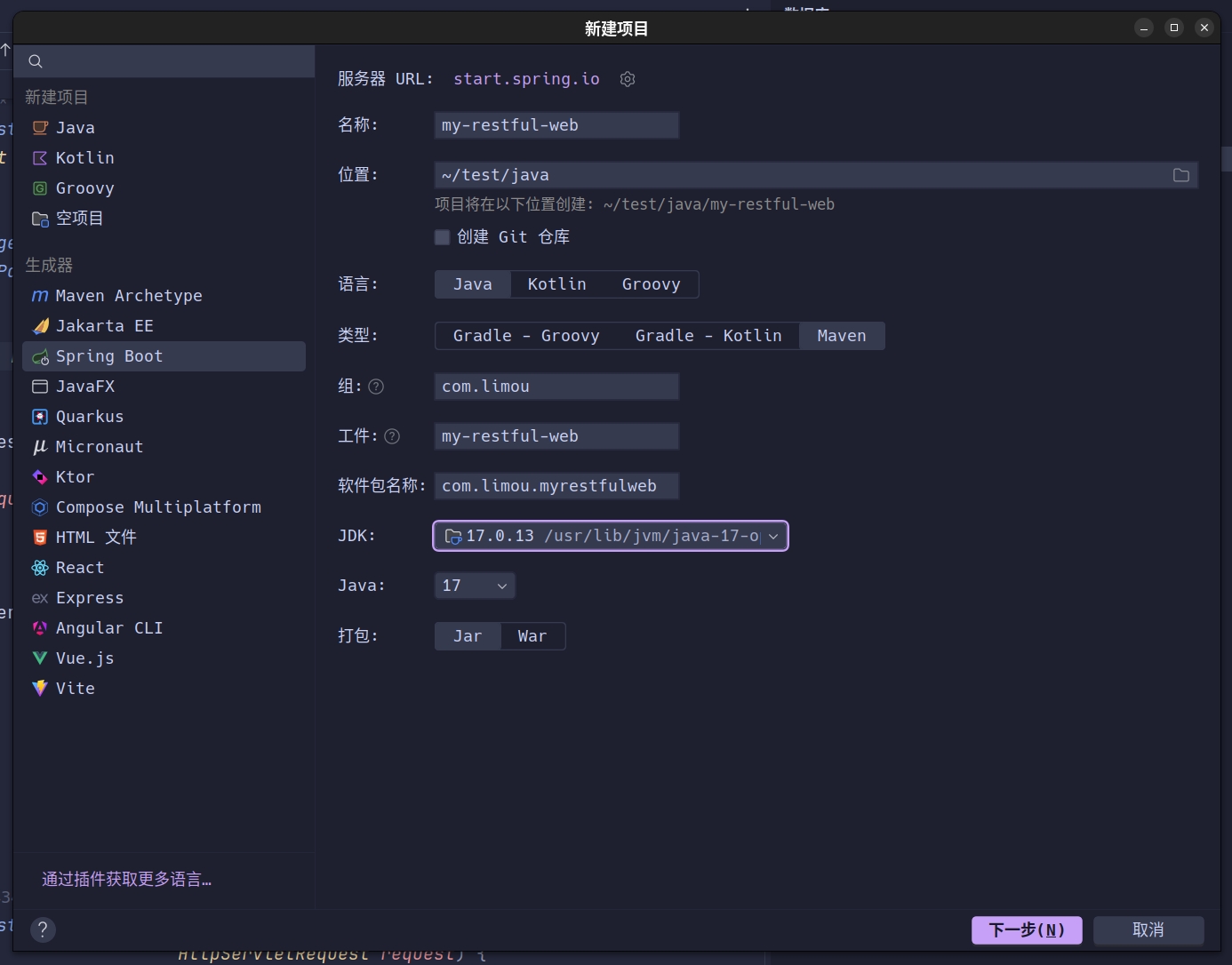

这次我们不再使用 Spring Initializr 来创建 Spring Boot 项目了,而使用著名的 IDEA 编辑器来构建一个 Spring Boot 项目。

重要

补充:注意观察这里的 “服务器 url”,您可以修改这里的地址为我们之前说的网址 https://start.aliyun.com/ 以支持更多过往版本的 Spring Boot。

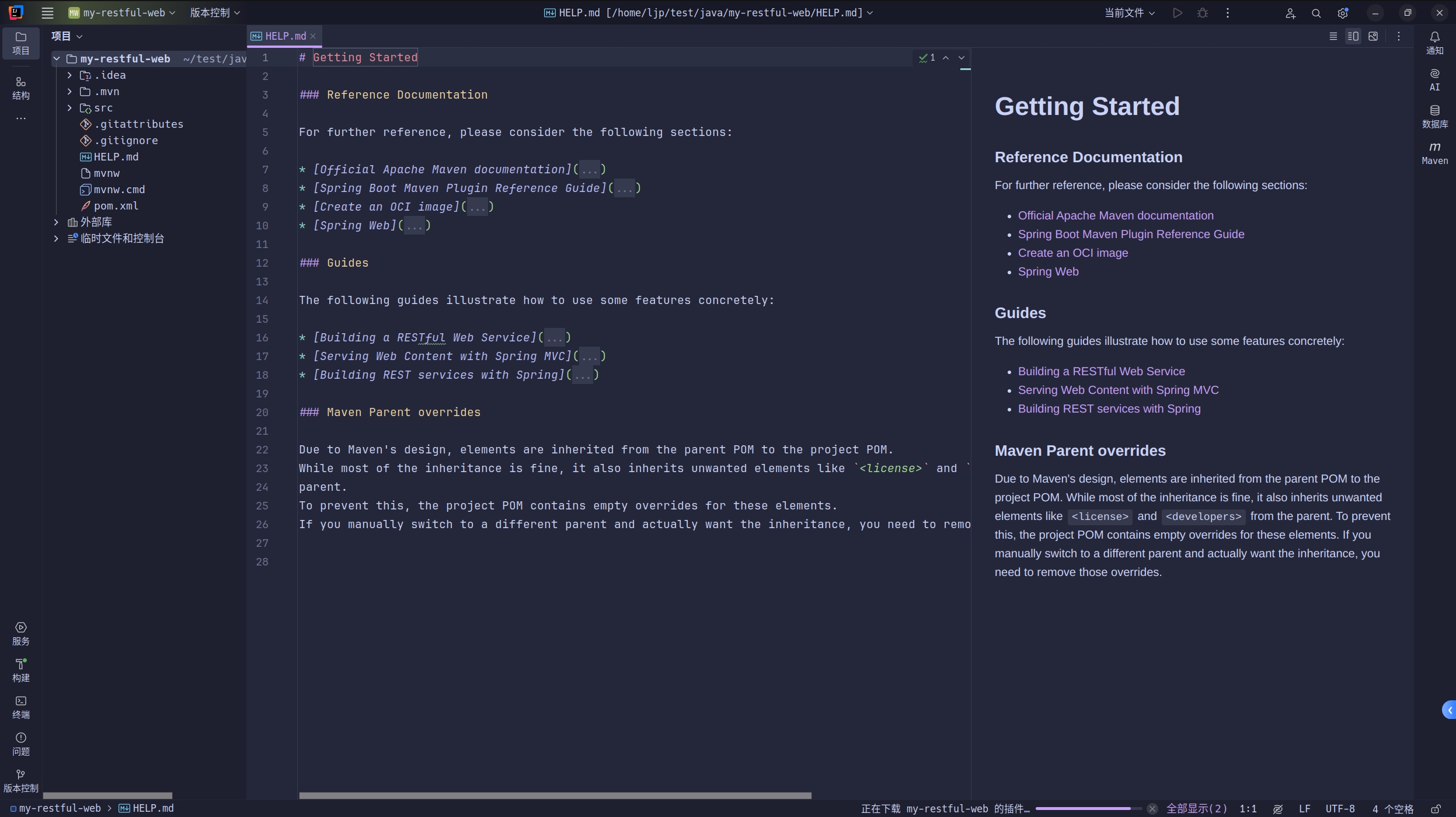

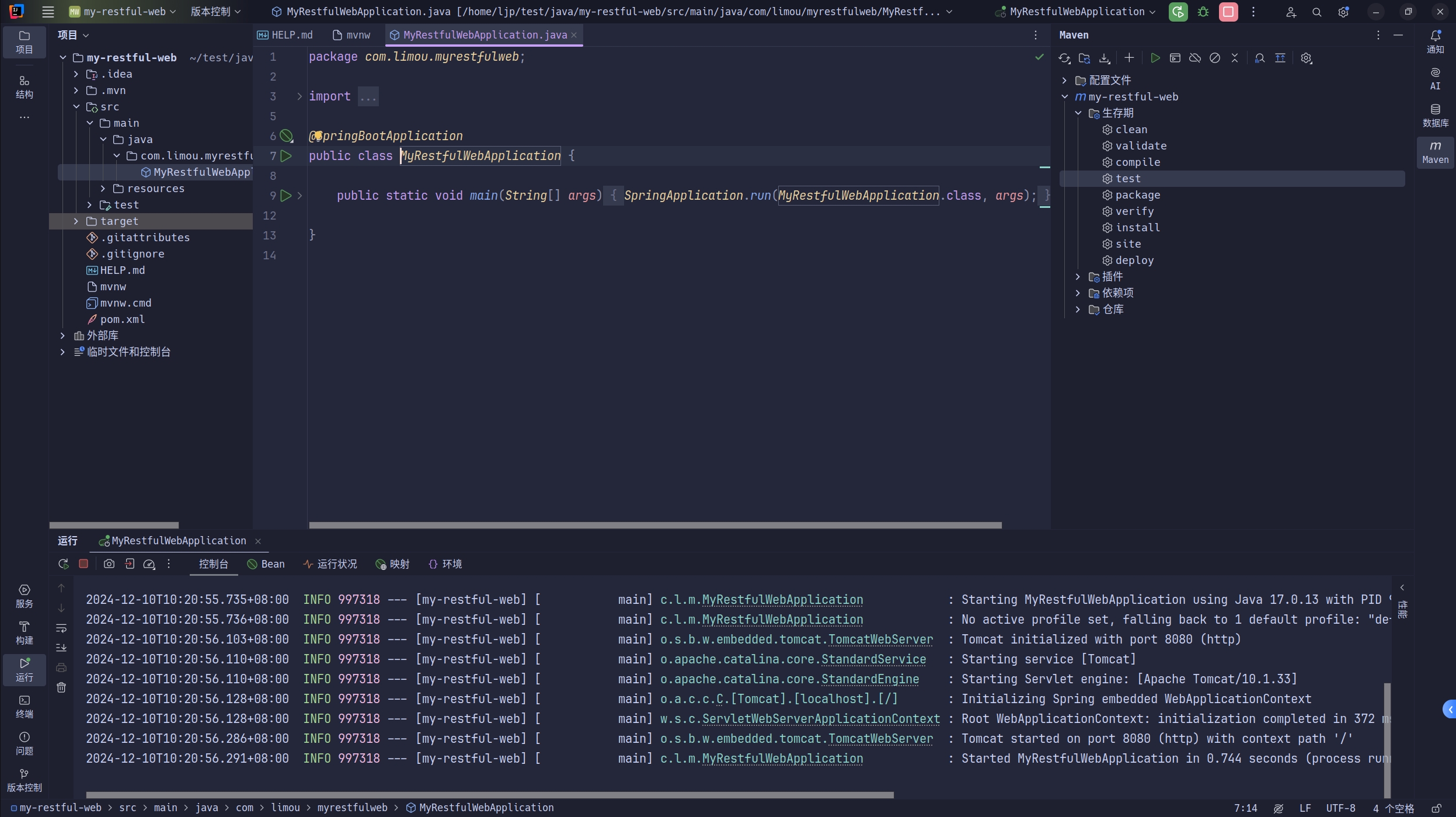

然后打开侧边的 Maven 执行和上一节一样的命令行操作,在生命周期中先点击 clean 再点击 install,最后打开启动文件,点击运行启动函数即可。

可以看到在终端中,Spring boot 成功被启动起来了。

1.3.2.3.简单使用

由于我们需要自定义返回的 JSON 字符串,因此需要使用一些 Resource Representation 来进行数据建模(就是下面定义的 Greeting)。

# 项目文件结构

$ tree my-restful-web

my-restful-web

├── HELP.md

├── mvnw

├── mvnw.cmd

├── pom.xml

├── src

│ ├── main

│ │ ├── java

│ │ │ └── com

│ │ │ └── limou

│ │ │ └── myrestfulweb

│ │ │ ├── Greeting.java # 我们将要编写的 "资源表示类"

│ │ │ ├── GreetingController.java # 我们将要编写的 "资源控制类"

│ │ │ └── MyRestfulWebApplication.class # 暂时不需要改动的 "启动文件"

│ │ └── resources # 资源文件目录

│ │ ├── application.properties

│ │ ├── static

│ │ └── templates

...// Greeting.java: 资源表示

package com.limou.myrestfulweb;

public record Greeting(long id, String content) {

/**

* record 会自动为类的字段生成以下内容:

*

* 常用方法:

* 构造函数

* getter()

* toString()

* equals()

* hashCode()

*

* 不可变性: record 中的字段是 final 的, 不能更改(在创建后即为只读), 没有提供 setter()

*/

}// GreetingController.java: 资源控制

package com.limou.myrestfulweb;

import java.util.concurrent.atomic.AtomicLong;

import org.springframework.web.bind.annotation.GetMapping;

import org.springframework.web.bind.annotation.RequestParam;

import org.springframework.web.bind.annotation.RestController;

@RestController

/**

* @RestController 表示这是一个资源控制类

* 其中每个方法都返回域对象而不是视图, 它是包括 @Controller 和 @ResponseBody 的简写

*/

public class GreetingController {

private static final String template = "Hello, %s!"; // 需要返回数据的模板

private final AtomicLong counter = new AtomicLong(); // 用于生成线程安全计数器的对象, 常用于对资源的访问进行计数或生成唯一标识符(ID), 具有一个 incrementAndGet() 可以对计数器进行递增

@GetMapping("/greeting")

/**

* @GetMapping 表示这是一个 Get 方法的映射接口

*

* @RequestMapping(method = RequestMethod.GET) <=> @GetMapping

* @RequestMapping(method = RequestMethod.POST) <=> @PostMapping

*

* 简而言之 @RequestMapping 可以用于处理任何 HTTP 方法的请求,而 @GetMapping、@PostMapping 等是专门为常见 HTTP 方法提供的简化版本

*/

public Greeting greeting(@RequestParam(value = "name", defaultValue = "World") String name) {

/**

* @RequestParam 表示做一个查询参数到函数参数的映射, 常用于 Get 方法中

* 'value' 是表单中的键值名

* '"name"' 是本函数的参数名

* 剩下的 'defaultValue' 就是当查询参数中没有传递时使用的默认值

*/

return new Greeting(counter.incrementAndGet(), String.format(template, name)); // 使用前面的资源表示类来进行数据返回(存放了一个不断递增的 ID 字段和一个 name 字段), 可以在浏览器上访问注意到: 这里返回的是一个对象, 严格来说只是一个引用, 但是在浏览器中自动被转化为 JSON 文档对象(自动序列化)

}

}// MyRestfulWebApplicationTests.java: 启动文件

// 注意无需进行任何改动!

package com.limou.myrestfulweb;

import org.springframework.boot.SpringApplication;

import org.springframework.boot.autoconfigure.SpringBootApplication;

/**

* @SpringBootApplication 是一个便捷的注释,它添加了以下所有内容:

* = @SpringBootConfiguration 标识这是一个 Spring Boot 应用程序的配置类

* + @EnableAutoConfiguration 启用 Spring Boot 的自动配置机制, 根据依赖和类路径内容自动配置应用程序, 避免手动配置大量的 Spring 配置类

* + @ComponentScan 启用组件扫描, 默认会扫描当前包及其子包中的所有类(如 @Controller, @Service, @Repository, @Component 等注解标记的类)

*/

@SpringBootApplication

public class MyRestfulWebApplication {

public static void main(String[] args) {

SpringApplication.run(MyRestfulWebApplication.class, args);

}

}重要

补充:Jackson JSON 库将 Greeting 类型的实例自动封送到 JSON 中。默认情况下,Jackson 由 Web 启动器包含。

注意

警告:在编码过程中请注意您的包名不一定和我一样...

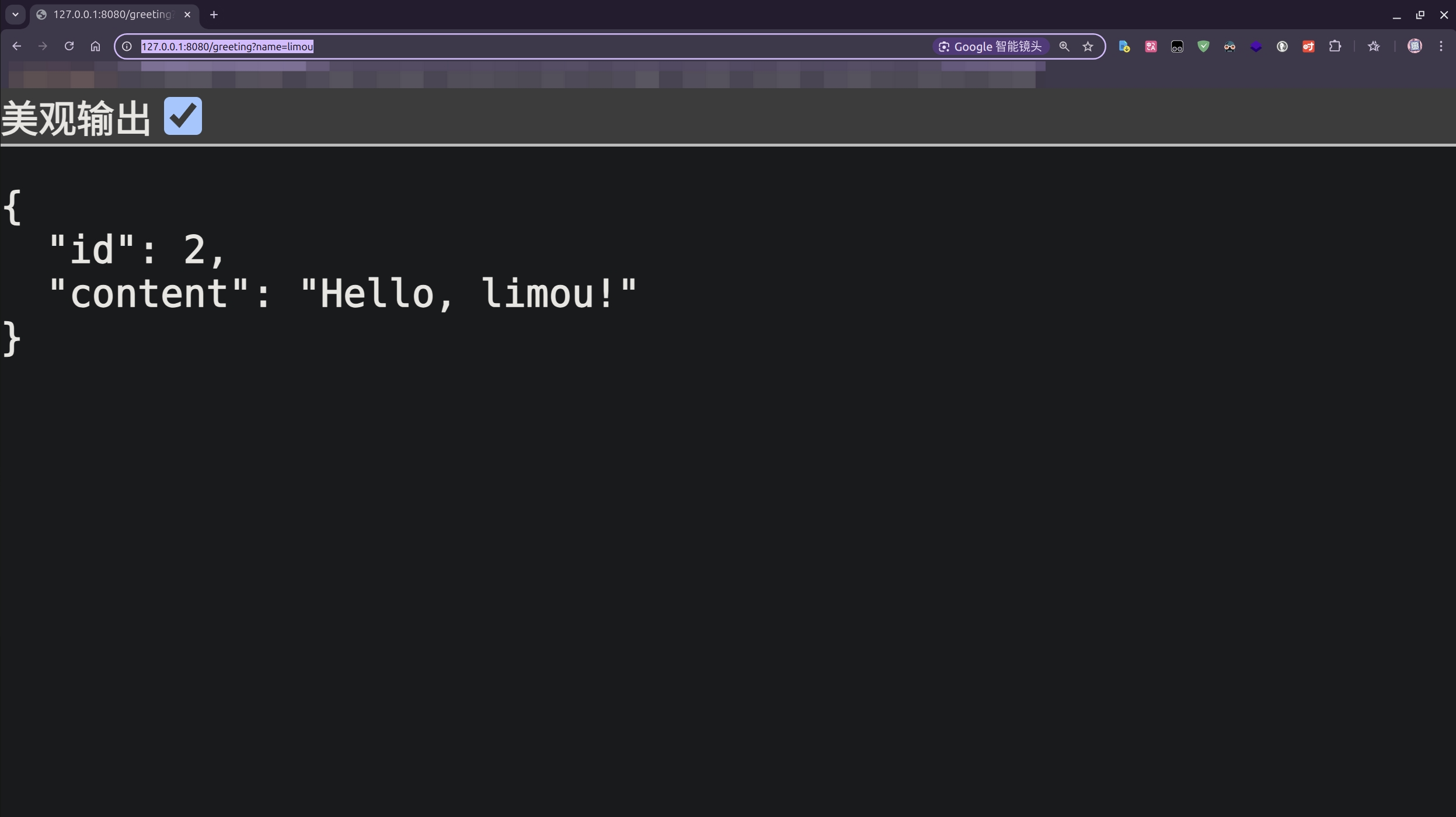

还是像上一小节一样运行 Spring Boot 不过这次我们可以使用 IDEA 快速点击运行,然后使用浏览器访问 http://127.0.0.1:8080/greeting(或者使用类似 http://127.0.0.1:8080/greeting?=limou 的写法)。

1.3.2.4.高自定义

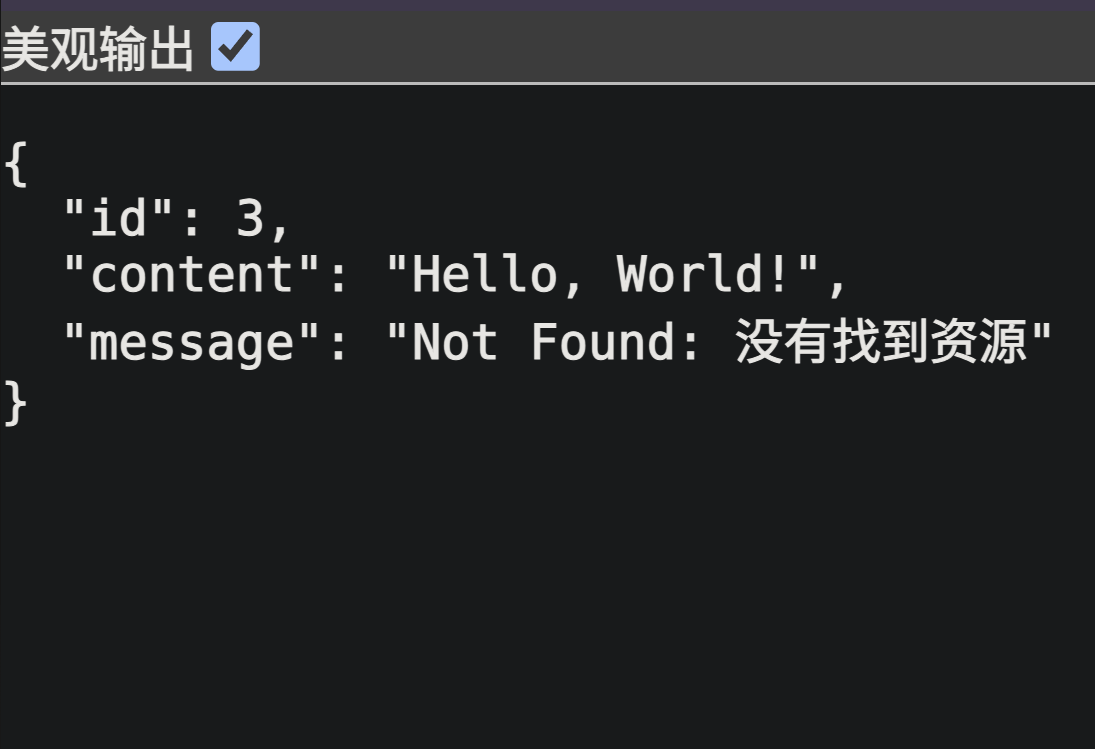

如果您对 HTTP 协议足够熟悉,您一定会像如何高自定义化网络报文的,因此下面给出了一个稍微现代化的写法供您参考,为节省一些说明,我把文件稍微精简了一些...

# 项目结构

$ tree my-restful-web

my-restful-web

├── HELP.md

├── mvnw

├── mvnw.cmd

├── pom.xml

├── src

│ ├── main

│ │ ├── html

│ │ │ └── test.html # 将要编写的 "前端页面"

│ │ ├── java

│ │ │ └── com

│ │ │ └── limou

│ │ │ └── myrestfulweb

│ │ │ ├── GreetingController.java # 将要编写的 "资源控制"

│ │ │ └── MyRestfulWebApplication.class # 不需要改动的 "启动文件"

│ │ └── resources

│ │ ├── application.properties # 将要编写的 "配置文件"

│ │ ├── static

│ │ └── templates

...// GreetingController.java: 资源控制

package com.limou.myrestfulweb;

import com.fasterxml.jackson.annotation.JsonIgnoreProperties;

import org.springframework.boot.autoconfigure.ssl.SslProperties;

import org.springframework.http.HttpHeaders;

import org.springframework.http.ResponseEntity;

import org.springframework.web.bind.annotation.*;

import java.io.File;

import java.io.IOException;

import java.nio.charset.StandardCharsets;

import java.nio.file.Files;

import java.nio.file.Paths;

import java.util.Map;

import java.util.concurrent.atomic.AtomicLong;

@RestController

/**

* @RestController 表示这是一个资源控制类

* 其中每个方法都返回域对象而不是视图, 它是包括 @Controller 和 @ResponseBody 的简写

*/

public class GreetingController {

// 1. 定义一些后面需要用的成员和方法

private static final String template = "Hello, %s!"; // 需要返回数据的模板

private final AtomicLong counter = new AtomicLong(); // 用于生成线程安全计数器的对象, 常用于对资源的访问进行计数或生成唯一标识符(ID), 具有一个 incrementAndGet() 可以对计数器进行递增

// @JsonIgnoreProperties(ignoreUnknown = true)

public record Name(String name) {} // 资源描述(请求)

public record Greeting(long id, String content, String message) {} // 资源描述(响应)

private static final Map<Integer, String> statusCodeToMessage = Map.of(

200, "OK: 成功",

404, "Not Found: 没有找到资源",

500, "Internal Server Error: 出现服务器问题"

); // 自定义错误码映射错误描述的函数

// 2. 演示如何 获取请求报文中的数据 和 设置响应报文中的数据(GET)

@GetMapping("/greeting_get")

/**

* @GetMapping 表示这是一个 Get 方法的映射接口

*

* @RequestMapping(method = RequestMethod.GET) <=> @GetMapping

* @RequestMapping(method = RequestMethod.POST) <=> @PostMapping

*

* 简而言之 @RequestMapping 可以用于处理任何 HTTP 方法的请求,而 @GetMapping、@PostMapping 等是专门为常见 HTTP 方法提供的简化版本

*/

public ResponseEntity<Greeting> greetingPlus(

@RequestParam(value = "name", defaultValue = "World") String name,

@RequestHeader("Cookie") String cookie,

@RequestBody(required = false) String requestBody) { // 如果传递的数据载荷中是 JSON 时这里其实会自动映射, 如果有未绑定的键可以使用 @JsonIgnoreProperties(ignoreUnknown = true) 来进行不严格匹配(后面的 POST 接口有演示)

// (1) 演示获取请求报文中的数据

/**

* @RequestParam 获取请求路径中的查询参数

* 常用于 Get 方法中

* 'value' 是表单中的键值名

* '"name"' 是本函数的参数名

* 剩下的 'defaultValue' 就是当查询参数中没有传递时使用的默认值

*/

/**

* @RequestHeader 获取请求头部中的键

* 这里获取的是 cookie

*/

/**

* @RequestBody 获取请求载荷中的键

* 不过一般 Get 方法很少有传递业务需要使用的键, 因此这里打印出来大概率是空, 毕竟浏览器没有传递任何的载荷

* 这里的 required = false 表示如果请求体为空, 则不会抛出异常

* 在 POST 方法中可以使用其他类型的对象来接受获取内部更加详细的数据

*/

System.out.println(name);

System.out.println(cookie);

System.out.println(requestBody);

// (2) 演示设置响应报文中的数据

// a. 准备报头数据

int customStatusCode = 404; // 错误码

HttpHeaders headers = new HttpHeaders();

headers.add("X-Custom-Message", "This is a custom message header");

// b. 准备载荷数据

String customStatusMessage = statusCodeToMessage.getOrDefault(customStatusCode, "Unknown status code"); // 错误描述

Greeting customResponse = new Greeting(counter.incrementAndGet(), String.format(template, name), customStatusMessage);

// (3) 使用函数调用链返回 ResponseEntity

return ResponseEntity

.status(customStatusCode) // 设置状态码

.headers(headers) // 设置响应头

.body(customResponse); // 设置响应体

}

// 3. 演示如何 获取请求报文中的数据 和 设置响应报文中的数据(POST)

@PostMapping("/greeting_post")

public ResponseEntity<Greeting> greeting_plus_post(

@RequestBody(required = false) Name nameObj) {

String name = "World";

if (nameObj!= null && nameObj.name!= null) {

name = nameObj.name;

System.out.println(nameObj);

}

// 准备报头数据

int customStatusCode = 200;

HttpHeaders headers = new HttpHeaders();

headers.add("X-Custom-Message", "This is a custom message header for POST request");

// 准备载荷数据

String customStatusMessage = statusCodeToMessage.getOrDefault(customStatusCode, "Unknown status code");

Greeting customResponse = new Greeting(counter.incrementAndGet(), String.format(template, name), customStatusMessage);

return ResponseEntity

.status(customStatusCode)

.headers(headers)

.body(customResponse);

}

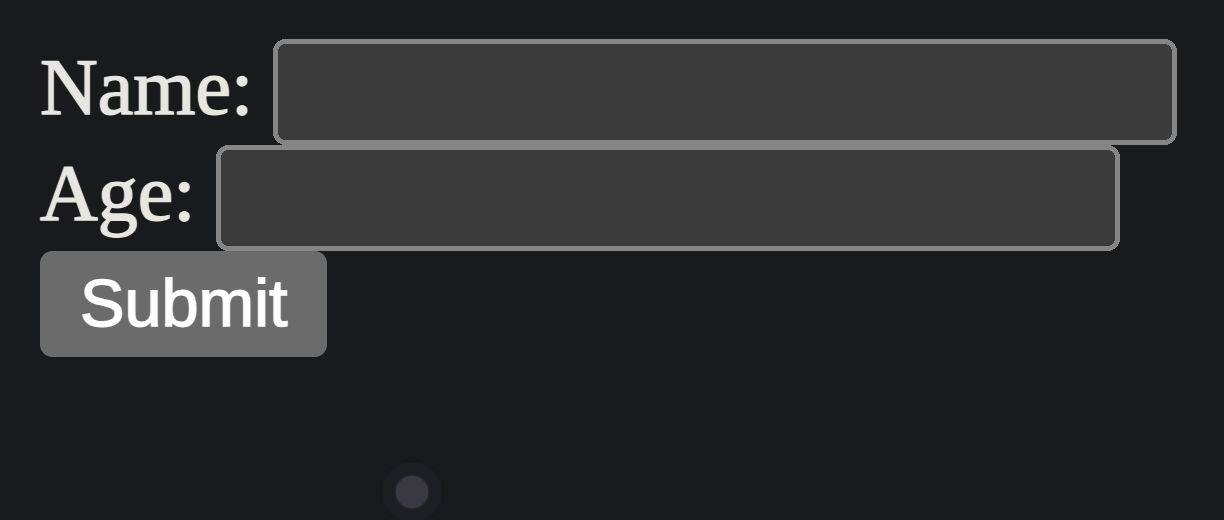

// 4.可以看到 Spring boot 也有能力做到 Spring MVC 一样返回一个完整的页面视图(不过这种方式不常用, 我这里之所以写这个接口仅仅是为了让您不至于遇到跨域问题从而进行麻烦的配置)

@GetMapping("/html")

public String getHTML() throws IOException {

File file = new File("/home/ljp/test/java/my-restful-web/src/html/test.html");

byte[] encoded = Files.readAllBytes(Paths.get(file.getAbsolutePath()));

return new String(encoded, StandardCharsets.UTF_8);

}

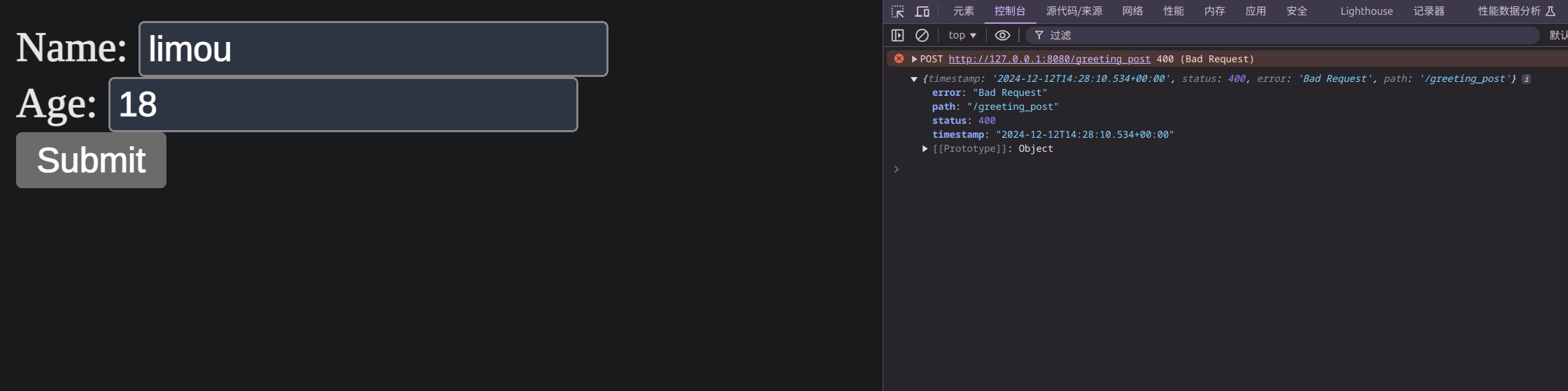

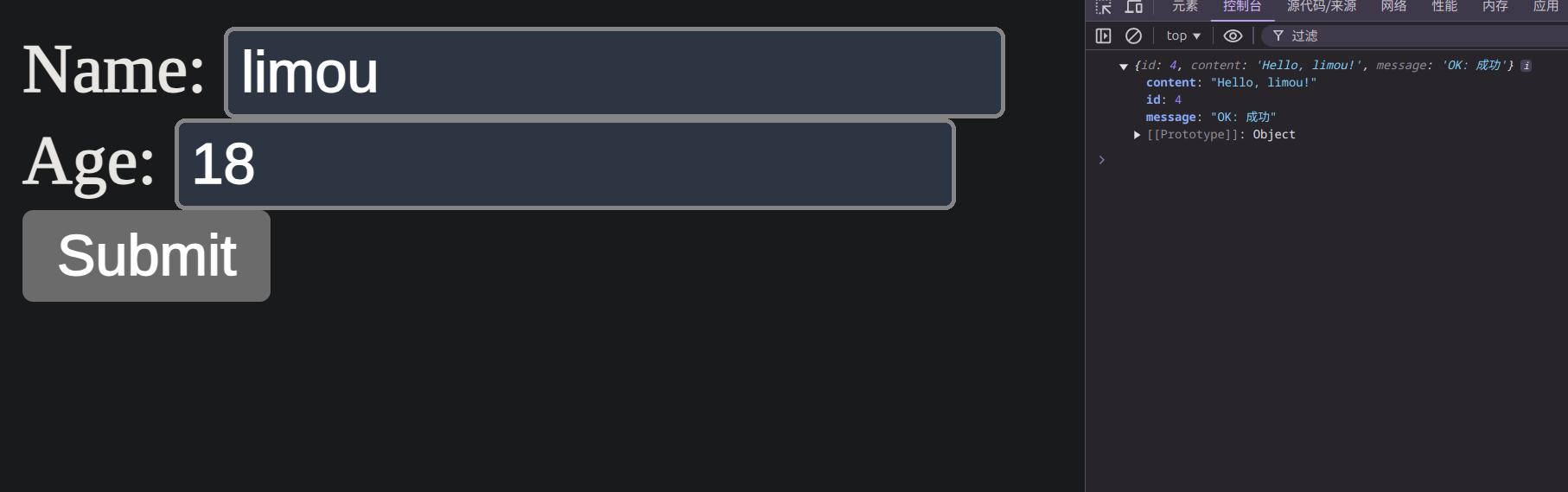

}<!-- test.html: 前端页面 -->

<!DOCTYPE html>

<html lang="en">

<head>

<meta charset="UTF-8">

<title>POST Request Example</title>

</head>

<body>

<form id="myForm">

<label for="name">Name:</label>

<input type="text" id="name" name="name"><br/>

<label for="age">Age:</label>

<input type="text" id="age" name="age"><br/> <!-- 这个字段后端是不需要处理的, 但是我依旧强行传递过去了 -->

<input type="submit" value="Submit">

</form>

<script>

document.getElementById('myForm').addEventListener('submit', function (e) {

e.preventDefault();

var name = document.getElementById('name').value;

var age = document.getElementById('age').value;

var requestBody = {

"name": name,

"age": age // 这里表单虽然传递给了后端, 但是由于后端的 "/greeting_plus_post" 接口内的资源表示类使用了 "@JsonIgnoreProperties(ignoreUnknown = true)" 注解, 因此不会抛出异常(您可以去掉这个注解试一试)

};

fetch('http://127.0.0.1:8080/greeting_post', {

method: 'POST',

headers: {

'Content-Type': 'application/json'

},

body: JSON.stringify(requestBody)

})

.then(response => response.json())

.then(data => {

console.log(data);

// 在这里可以根据返回的数据进行进一步的页面展示等操作,比如显示响应中的消息等

})

.catch(error => {

console.error('Error:', error);

});

});

</script>

</body>

</html># application.properties: 配置文件

spring.application.name=my-restful-web

spring.jackson.deserialization.fail-on-unknown-properties=true # 加上这一句就可以

# 注意这个文件不可以加入任何注释, 记得删除我在这里写的注释// MyRestfulWebApplicationTests.java

// 注意无需进行任何改动!

package com.limou.myrestfulweb;

import org.springframework.boot.SpringApplication;

import org.springframework.boot.autoconfigure.SpringBootApplication;

/**

* @SpringBootApplication 是一个便捷的注释,它添加了以下所有内容:

* = @SpringBootConfiguration 标识这是一个 Spring Boot 应用程序的配置类

* + @EnableAutoConfiguration 启用 Spring Boot 的自动配置机制, 根据依赖和类路径内容自动配置应用程序, 避免手动配置大量的 Spring 配置类

* + @ComponentScan 启用组件扫描, 默认会扫描当前包及其子包中的所有类(如 @Controller, @Service, @Repository, @Component 等注解标记的类)

*/

@SpringBootApplication

public class MyRestfulWebApplication {

public static void main(String[] args) {

SpringApplication.run(MyRestfulWebApplication.class, args);

}

}

重要

补充:如果不在 application.properties 配置文件中加入 spring.jackson.deserialization.fail-on-unknown-properties=true 就会默认不约束 JSON 报文数据。但是如果加上了,并且没有对资源描述做 // @JsonIgnoreProperties(ignoreUnknown = true) 忽略,在有字段缺失时,就会抛出异常。

重要

补充:@JsonIgnoreProperties 其实还有一些其他的用法,比如对某些特定字段进行忽略...

警告

警告:上述代码中有一个 /html 的接口,可以直接组合 HTML 返回一个前端页面,这是前后端不分离的做法,也就是类似 Spring MVC 的做法,Spring Boot 开发一般不会这么做,这只是我为了进行方便的测试 POST 方法而已。

当然,如果您不希望使用 Spring Boot 做页面返回这种奇怪的做法(毕竟几乎没有人会这么做),可以在启动文件中定义一个定义一个 RestTemplate 客户端,用来模拟浏览器进行接口测试(这是 Spring 提供的),只需要在启动文件中加入一些代码即可。

// MyRestfulWebApplicationTests.java: 启动文件

// 注意无需进行任何改动!

package com.limou.myrestfulweb;

import org.slf4j.Logger;

import org.slf4j.LoggerFactory;

import org.springframework.boot.CommandLineRunner;

import org.springframework.boot.SpringApplication;

import org.springframework.boot.autoconfigure.SpringBootApplication;

import org.springframework.boot.web.client.RestTemplateBuilder;

import org.springframework.context.annotation.Bean;

import org.springframework.context.annotation.Profile;

import org.springframework.http.HttpEntity;

import org.springframework.http.HttpHeaders;

import org.springframework.http.HttpMethod;

import org.springframework.http.ResponseEntity;

import org.springframework.web.client.RestTemplate;

/**

* @SpringBootApplication 是一个便捷的注释,它添加了以下所有内容:

* = @SpringBootConfiguration 标识这是一个 Spring Boot 应用程序的配置类

* + @EnableAutoConfiguration 启用 Spring Boot 的自动配置机制, 根据依赖和类路径内容自动配置应用程序, 避免手动配置大量的 Spring 配置类

* + @ComponentScan 启用组件扫描, 默认会扫描当前包及其子包中的所有类(如 @Controller, @Service, @Repository, @Component 等注解标记的类)

*/

@SpringBootApplication

public class MyRestfulWebApplication {

public static void main(String[] args) {

SpringApplication.run(MyRestfulWebApplication.class, args);

}

private static final Logger log = LoggerFactory.getLogger(MyRestfulWebApplication.class);

@Bean

public RestTemplate restTemplate(RestTemplateBuilder builder) {

return builder.build();

}

@Bean

@Profile("!test")

public CommandLineRunner run(RestTemplate restTemplate) throws Exception {

return args -> {

try {

String getUrl = "http://127.0.0.1:8080/greeting_get?name=gimou";

// 创建请求头

HttpHeaders headers = new HttpHeaders();

headers.add("Cookie", "your_cookie_value"); // 在这里添加 Cookie 请求头

// 创建 HttpEntity 并将请求头和请求体设置进去

HttpEntity<String> entity = new HttpEntity<>(null, headers); // 请求体为 null

// 使用 exchange 方法发送请求

ResponseEntity<GreetingController.Greeting> getResponse =

restTemplate.exchange(

getUrl, // 请求的 URL

HttpMethod.GET, // 请求方法

entity, // 请求实体,包括头信息

GreetingController.Greeting.class // 响应体类型

);

// 打印响应结果

log.info("Response: {}", getResponse.getBody());

} catch (Exception e) {

// 捕获所有异常并记录日志

log.error("An error occurred while making the request: {}", e.getMessage(), e);

}

};

}

}- 使用上述代码中的

RestTemplate同步客户端根据来测试(不太推荐) - 使用已经编写好的前端程序,用浏览器进行调试,例如

Chrome(但要有前端代码) - 使用一些现成的接口调用软件,在本地进行测试,例如

Postman(比较不错) - 使用命令行进行测试,例如

wget, telnet(更加直观但难上手)

重要

补充:使用 RestTemplate 的方式其实意味着 Spring Boot 也是可以开发一个前端的,不过这种前端是无界面的前端,更加适合在终端中执行。

重要

补充:不知道您有没有注意到一些问题,我们的确定义了两个东西:

- 资源表示类

- 资源控制类

但是值得令人好奇的是,我们没有调用资源控制类的对象,仅仅是在内部使用了资源表示类的对象,但是浏览器却能调用资源控制类内部的方法,这其实和 Bean 机制有关。

在 Spring 框架中,Bean 是指由 Spring 容器管理的对象。Spring 使用 DI(依赖注入) 机制来创建和管理这些对象,确保对象之间的依赖关系得到正确处理。Spring 容器通过配置文件、注解或 Java 配置类来管理这些 Bean。

而实际上 Bean 就是一个普通的 Java 对象,但是它被 Spring 容器 创建、管理、注入 到其他对象中。

Spring 容器通过使用注解(如 @Component、@Service、@Repository)或 XML 配置文件来标识哪些类是 Bean,并将这些对象注册到 Spring 容器中。

不过更多的原理,我认为可以转移到 Spring 那里去理解,毕竟 Spring Boot 可以理解为基于 Spring 的封装。

在上述代码中:

- 资源控制类 是由

Spring容器自动管理的Bean,Spring会根据配置的URL映射来自动调用控制器类的方法 - 资源表示类(如

Greeting)用于封装返回给客户端的数据。GreetingController类内部使用了Greeting类,但不需要显式地调用GreetingController实例 - 通过

Bean管理和 自动映射,Spring会自动处理HTTP请求并执行相应的方法,开发者无需手动实例化和调用控制器类

1.4.深入学习

1.4.1.启动流程

Spring Boot 的启动流程可以总结为以下几个核心步骤(示例为 Spring Boot 2.7.6 版本):

启动 main() 方法:应用从

main()方法启动,并通过SpringApplication.run()引导应用启动。创建 SpringApplication:应用会创建

SpringApplication对象,推断应用类型、设置初始化器、设置启动监听器、确定主应用类。准备环境:

Spring Boot在启动过程中准备应用环境,加载配置文件、系统环境变量以及命令行参数。创建并刷新 ApplicationContext:创建应用上下文,加载配置类和自动配置类,注册

Bean并执行依赖注入等初始化操作。在刷新上下文时启动嵌入式 Web 服务器:对于

Web应用,Spring Boot 会自动启动嵌入式Web容器(如Tomcat),并注册相关的Servlet和Filter。重要

补充:

Servlet是Java EE规范的一部分,本质上是处理HTTP请求的一个类。- 用于接收请求(如

GET、POST) - 处理业务逻辑

- 响应数据客户(返回

HTML、JSON等)

总结就是核心业务处理。

重要

补充:

Filter是一种“过滤器”,可以在请求到达Servlet之前 或响应返回客户端 之后 做处理。常用于:- 权限校验

- 日志记录

- 编码设置

- 跨域处理

总结就是拦截器/中间件。

重要

补充:一般

Spring通过@WebServlet/@WebFilter注解 +@ServletComponentScan,不过在Spring Boot中如果使用@RestController则会自动配置,除非又特殊场景才会手动使用(例如日志处理)。- 用于接收请求(如

发布应用已启动事件:对应监听

stated事件逻辑会被触发。执行 CommandLineRunner 和 ApplicationRunner:在应用启动完成后,执行实现了

CommandLineRunner和ApplicationRunner接口的初始化逻辑。发布 ready 事件、应用启动完成:触发

ApplicationReadyEvent,应用进入运行状态,处理业务请求或任务。

1.4.2.生命周期

待补充...

1.4.3.注解说明

这部分注解是 Spring Boot 框架自己携带的注解。

@Configuration:定义「配置逻辑」,批量注册 / 组装 Bean@Valid注解// 子 DTO @Data public class AddressDTO { @NotBlank(message = "收货地址不能为空") private String detail; @NotBlank(message = "手机号不能为空") private String phone; } // 顶层 DTO @Data public class OrderDTO { @NotBlank(message = "订单号不能为空") private String orderNo; // 关键:嵌套的 AddressDTO 需要加@Valid 才会触发校验 @Valid // 不加这个注解,AddressDTO 的@NotBlank 不会生效 private AddressDTO address; } // 接口中也要使用 @RestController public class OrderController { @PostMapping("/create") public String createOrder(@RequestBody @Valid OrderDTO orderDTO) { // 加@Valid 后,既校验 orderDTO 的 orderNo,也校验 address 的 detail/phone return "订单创建成功"; } }@NotBlank:校验字符串为非空或非空白的

1.4.4.加载配置

Spring Boot 中让容器加载配置类 Bean 的 “扫描 / 导入” 方式有很多,下面从高到低,列出类各种配置的使用规则:

AutoConfiguration.imports 文件(文件级显式导入,官方推荐):Spring Boot 2.7 + 官方推荐的自动配置导入方式,在

META-INF/spring/org.springframework.boot.autoconfigure.AutoConfiguration.imports文件中写入配置类全路径,启动时优先加载(旧版方式META-INF/spring.factories文件(2.7 前的替代方案),官方不推荐新项目使用)。一般在使用一些非常重要的核心组件配置中使用(比如数据库组件)@Import 注解(代码级显式导入):在任意配置类 / 启动类上,直接导入指定的配置类,无视包扫描范围,一般比较少用(其中

@MapperScan(MyBatis 专属扫描)专门扫描 MyBatis 的 Mapper 接口(替代每个 Mapper 加@Mapper),属于 “业务组件的精准扫描”,就是这个注解的封装)Spring Boot 内置自动配置类(如 DataSourceAutoConfiguration):这种一般也比较少用,有遇到再说

使用 @ComponentScan/@SpringBootApplication 注解:其中后者包含前者

@Conditional 系列注解(条件加载):满足指定条件时才加载配置类 / 创建 Bean,比如:

@ConditionalOnClass:存在指定类时加载(如存在 MyBatis-Plus 类才加载其插件配置);@ConditionalOnMissingBean:容器中没有指定 Bean 时才创建(如没有数据源时才加载自定义数据源);@ConditionalOnProperty:配置文件中有指定属性时加载(如配置了custom.datasource.enable=true才加载)。

重要

补充:官方推荐 AutoConfiguration.imports 方式的原因。

- 自定义自动配置类(比如数据源)需要「高优先级、早加载」

- 避免组件扫描的漏扫问题

- 符合 Spring Boot 自动配置的生命周期规范

- 自动配置的加载时机 ——“先于业务组件,晚于核心环境”

- 自动配置的优先级 ——“显式导入 > 内置默认 > 业务扫描”

- 自动配置的隔离性 ——“不依赖组件扫描,避免漏加载”

- 自动配置的条件约束 ——“按需加载,避免无效配置”

我相信您一定能明白注解对于 Spring Boot 的重要性,因此这里补充一些关于常见注解的详细讲解,您需要按需加入到您的应用中,并且值得注意的是,每一组相关的组件我都会用足够完整的代码供您测试。

@SpringBootApplication = @SpringBootConfiguration + @EnableAutoConfiguration + @ComponentScan标识Spring Boot应用程序的配置类、启用Spring Boot的自动配置机制、启用组件扫描来自动管理实例@RestController = @Controller + @ResponseBody:控制器@GetMapping = @RequestMapping(method = RequestMethod.GET):映射Get方法的接口@PostMapping = @RequestMapping(method = RequestMethod.POST):映射Post方法的接口@RequestParam: 获取路径中的查询参数@RequestHeader:请求报头,从请求报头中获取字段值@RequestBody:请求载荷,从请求载荷中获取字段值@JsonIgnoreProperties:对资源描述类约束的控制

1.4.5.常见工具

这部分注解是在 Spring Boot 框架上集成其他依赖后携带的常见注解工具。

1.4.5.1.开发工具

这里着重引入一个叫 Lombok 的开发依赖,他可以为 Spring Boot 提供一些加强的注解。

首先需要引入依赖...

@NonNull:当你在字段上使用@NonNull,Lombok会在它生成的方法(如构造器、setter等)中自动加入非空判断import lombok.NonNull; import lombok.Setter; @Setter public class User { @NonNull private String name; } // 等价代码 // public void setName(String name) { // if (name == null) { // throw new NullPointerException("name is marked non-null but is null"); // } // this.name = name; // }@RequiredArgsConstructor:可以为final字段(或标有@NonNull表示不为空的非final字段)自动生成对应的构造函数,通常用来配合Spring实现“通过构造器进行依赖注入(官方推荐)”,而final字段只能在构造器中赋值,这保证了依赖的不可变性和完整性@RequiredArgsConstructor public class UserController { private final UserService userService; // 会包含在生成的构造函数中 } // 等价代码 // public class UserController { // private final UserService userService; // 会包含在生成的构造函数中 // public UserController(UserService userService) { // this.userService = userService; // } // }

1.4.5.2.测试工具

Spring Boot 框架天然就是支持单元测试的好料子,因此这里必须给您推荐单元测试的工具。

首先需要引入依赖...

并且通常我们会把测试类放在 src/test/java 目录下(与 src/main/java 下的文件一一对应),并且当被测类叫 Xxx 时,测试类就叫 XxxTest。

而对于测试类内部的测试方法,通常有以下的常见注解。

| 注解 | 作用 | 说明 |

|---|---|---|

@Test | 标记一个方法是测试方法 | 每个测试方法必须有它 |

@BeforeEach | 在 每个 测试方法 之前 执行 | 用于初始化(如 new 对象) |

@AfterEach | 在 每个 测试方法 之后 执行 | 用于清理(如关闭连接) |

@BeforeAll | 在 整个测试类开始前 执行一次 | 静态方法,用于全局初始化 |

@AfterAll | 在 整个测试类结束后 执行一次 | 静态方法,用于全局清理 |

并且在测试中,我们通常会使用断言来对某个结果进行预计判断。

| 断言方法 | 作用 |

|---|---|

assertEquals(expected, actual) | 判断两个值是否相等 |

assertTrue(condition) | 判断条件为 true |

assertFalse(condition) | 判断条件为 false |

assertNull(object) | 判断对象为 null |

assertNotNull(object) | 判断对象不为 null |

assertThrows(Exception.class, () -> {...}) | 判断后面表达式是否会抛出前面指定的异常 |

使用 ./mvn test 就可以允许所有的测试类进行统一的单元测试,实际上 JUnit 只是一个通用的 Java 单元测试框架。它只依赖 Java 标准库(JDK),不需要任何外部框架。Spring Boot 默认集成了 JUnit,是为了让您更方便地测试 Spring 组件,因此我们通常不需要编写版本。值得注意的是,单纯的使用 Junit 不会用来直接测试接口层,而是用来测试非接口层的方法(测试接口层的我们后续会介绍,也就是使用 Mock)。

package cn.com.edtechhub.worktopicselection.utils;

import cn.hutool.http.Header;

import org.junit.jupiter.api.Test;

import org.junit.jupiter.api.extension.ExtendWith;

import org.mockito.Mock;

import org.mockito.junit.jupiter.MockitoExtension;

import javax.servlet.http.HttpServletRequest;

import static org.junit.jupiter.api.Assertions.assertEquals;

import static org.mockito.Mockito.when;

@ExtendWith(MockitoExtension.class)

class DeviceUtilsTest {

/**

* Mock 对象,模拟 HTTP 客户端请求

*/

@Mock

private HttpServletRequest request;

@Test

public void testGetRequestDevice_PC() {

// 预设 request.getHeader("User-Agent") 返回 PC 端的 User-Agent

String pcUserAgent = "Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/142.0.0.0 Safari/537.36";

when(

request.getHeader(Header.USER_AGENT.toString()) // 调用 Mock 的 request 对象的 getHeader 方法,参数是 Header.USER_AGENT.toString()(即 "User-Agent")

)

.thenReturn(pcUserAgent) // 当【Mock对象.方法(参数)】被调用时,返回【预设值】

;

String device = DeviceUtils.getRequestDevice(request);

assertEquals("pc", device);

}

}但是测试场景会设计一些特殊状况,还有一些比较好用的注解也必须去了解,待补充...

@ParameterizedTest

@CsvSource2.Spring AI

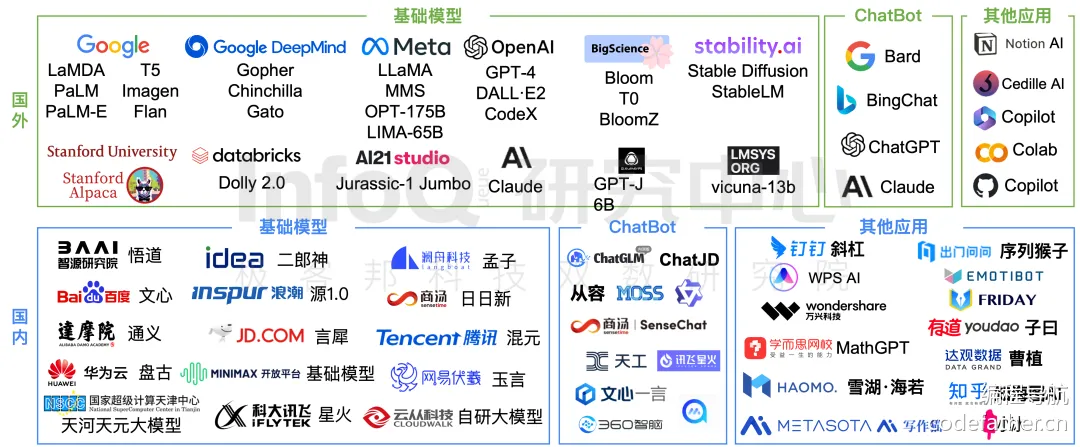

2.1.全面概述

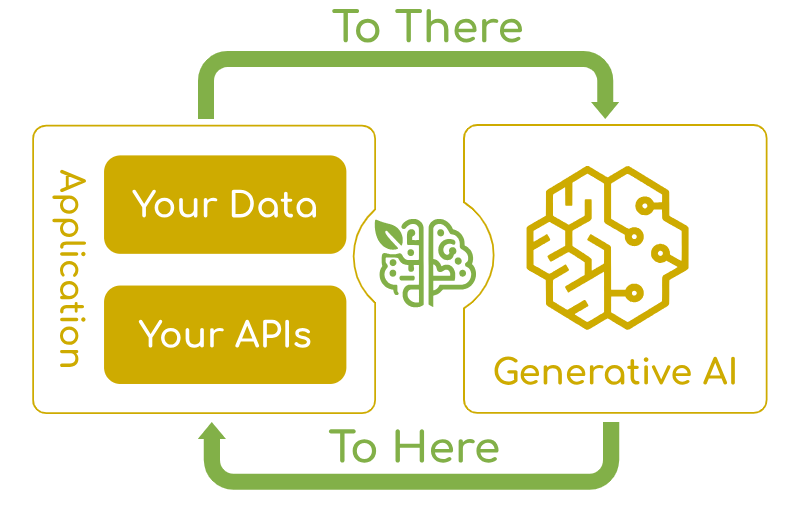

Spring AI 项目旨在简化包含人工智能功能的应用程序的开发,而不会产生不必要的复杂性。该项目从著名的 Python 项目(如 LangChain 和 LlamaIndex)中汲取灵感,但 Spring AI 并不是这些项目的直接移植。该项目的成立理念是,下一波生成式 AI 应用程序将不仅适用于 Python 开发人员,而且将在许多编程语言中无处不在。

官方文档认为,Spring AI 解决的痛点问题是:将企业数据和 api 与 AI 模型连接起来。

重要

补充:另外一个集成 AI 的 Java 框架就是 Langchain4j,您可以简单了解一下。

2.2.基本功能

支持所有主要 的 AI 模型提供商 ,例如

Anthropic、OpenAI、Microsoft、Amazon、Google 和 Ollama支持的模型类型包括:

支持跨

AI提供商的同步处理API和流式处理API选项,并且可移植,还可以访问特定于模型的高级功能(说白了就是有些AI厂家提供了一些独有的功能)结构化输出,从

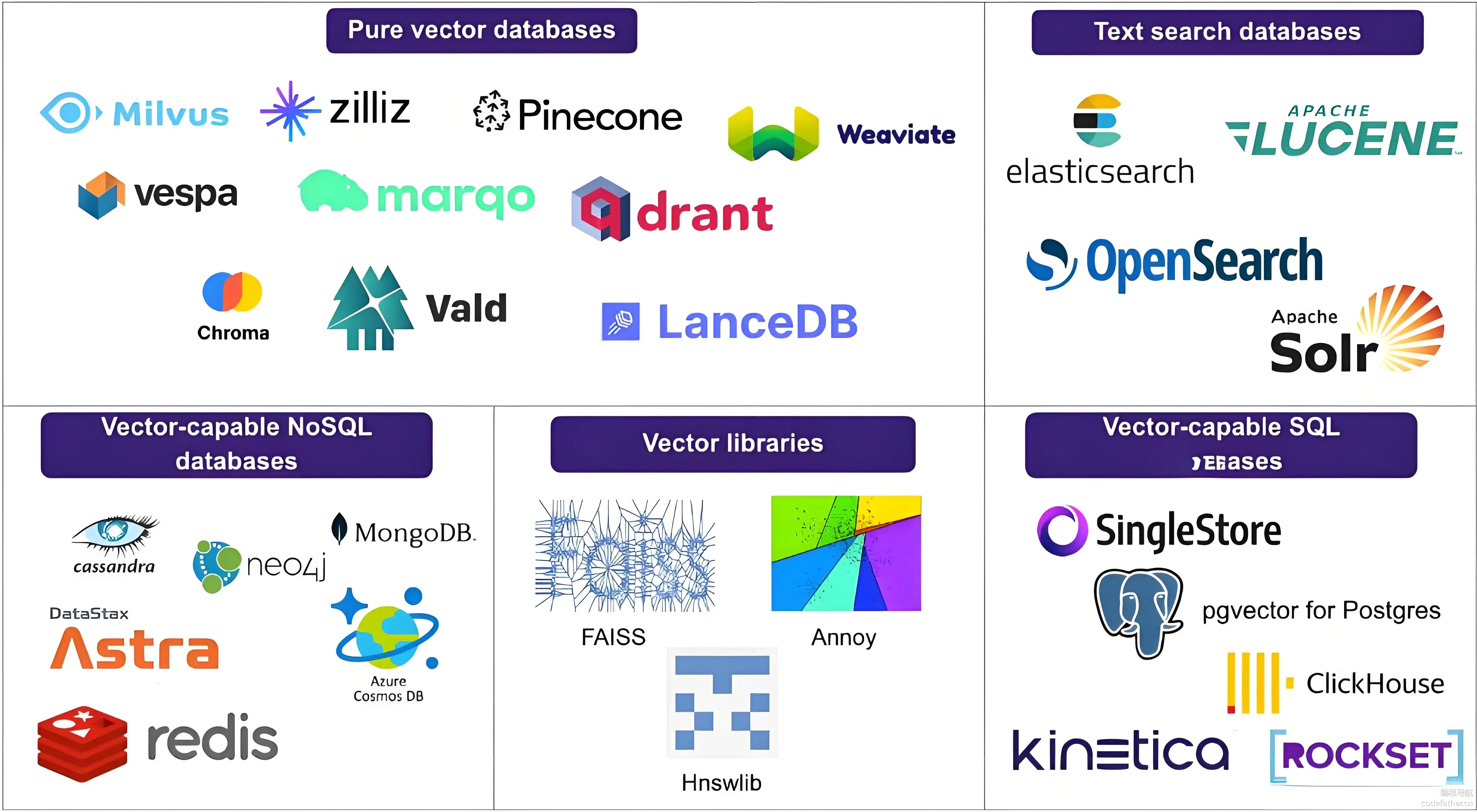

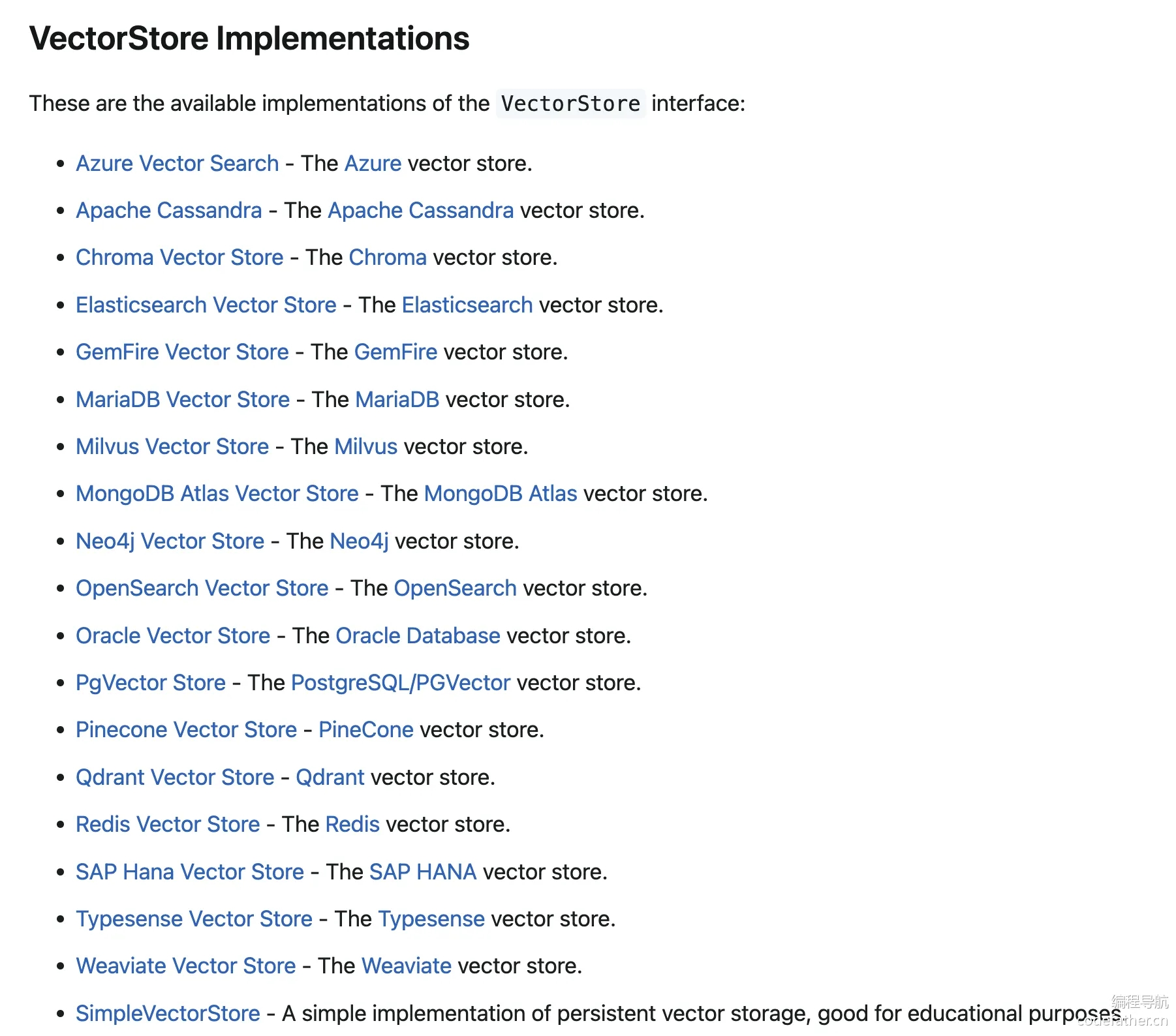

AI模型输出到POJO的映射支持所有主要的 矢量数据库提供商,例如

Apache Cassandra、Azure Vector Search、Chroma、Milvus、MongoDB Atlas、Neo4j、Oracle、PostgreSQL/PGVector、PineCone、Qdrant、Redis、Weaviate...

在没有 Spring AI 之前,一般使用 AI 有以下的方式:

- 网页端

- 本地大模型

- 某些应用内置引入

- 平台引入,例如:阿里云百炼模型可视化平台、阿里云模型服务灵积

DashScope - 客户端引入,例如:全能

AI助手平台Cherry Studio、编程开发工具Cursor - 程序引入,例如:特定平台提供的

SDK或API,其他的AI开发框架,比如LangChain4j

- 平台引入,例如:阿里云百炼模型可视化平台、阿里云模型服务灵积

而现在 Java 语言有能享用 AI 的福利,主要依赖两个框架:Spring AI 和 Spring AI Alibaba。

2.3.快速使用

3.1.基本知识

首先我们需要了解一些基础的 AI 知识才能开始使用 Spring AI,我们不着急使用。并且注意,除了 Spring AI,还有一个加强版的 Spring AI Alibaba,由阿里云官方进行维护。

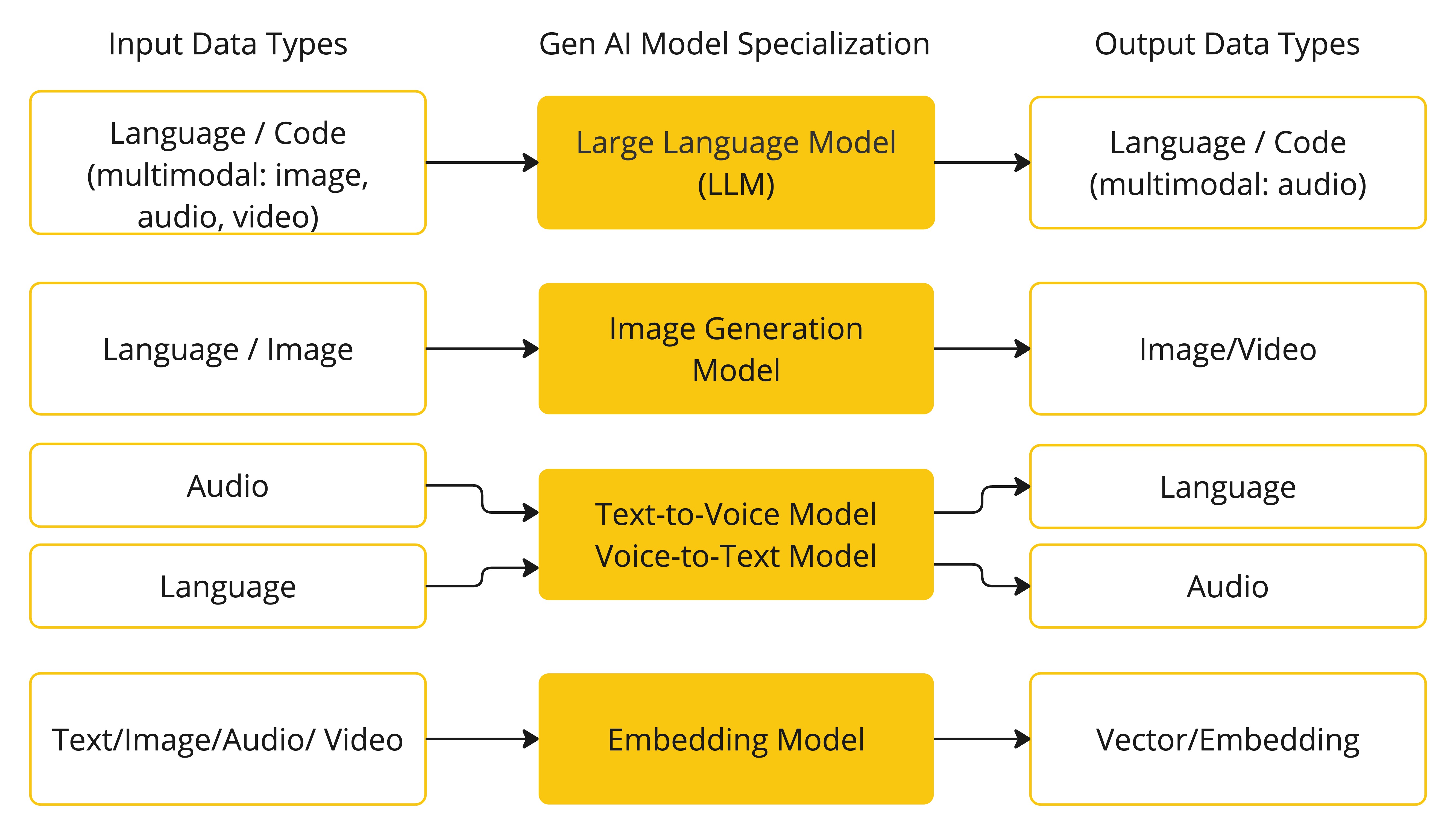

3.1.1.模型

AI 模型是旨在处理和生成信息的算法,通常模仿人类的认知功能。通过从大型数据集中学习模式和见解,这些模型可以进行预测、文本、图像或其他输出,从而增强跨行业的各种应用程序。有许多不同类型的 AI 模型,每种模型都适用于特定的使用案例。虽然 ChatGPT 及其生成式 AI 功能通过文本输入和输出吸引了用户,但许多模型和公司都提供了不同的输入和输出。在 ChatGPT 之前,许多人对 Midjourney 和 Stable Diffusion 等文本到图像生成模型着迷。根据用途,常见的模型可以分为四种:

- 语言模型

- 图像模型

- 音频模型

- 嵌入模型

Spring AI 对这些模型都做了相应的支持,不过类似 GPT 这种模型会比较特殊一些,GPT 的 P 代表预训练,预训练让 AI 更容易用。而因为它是预训练的,您不需要训练它、您不需要懂机器学习、您只要提供 Prompt, 提示 就能做很多事。

| 模型 | 特点 |

|---|---|

| GPT-4o/GPT-4/GPT-3.5 Turbo | 多模态/文本+图像/主要处理文本 |

| Claude 3 系列(Opus, Sonnet, Haiku,由强到弱) | 多模态 |

| Gemini Ultra/Pro/Nano | 多模态 |

| Llama 3/Llama 2 | 开源,70B 和 8B 参数版本/开源,多种参数规模 |

| 文心一言/通义千问/豆包/星火/Deepseek | 国产大模型 |

3.1.2.提示

提示是基于语言的输入的基础,这些输入可指导 AI 模型生成特定输出。对于熟悉 ChatGPT 的人来说,提示可能看起来只是在发送到 API 的对话框中输入的文本。然而,它包含的远不止于此。在许多 AI 模型中,提示的文本不仅仅是一个简单的字符串。

ChatGPT 的 API 在一个提示中有多个文本输入,每个文本输入都分配了一个角色。例如,有 system 角色,它告诉模型如何行为并设置交互的上下文。还有 user role,通常是来自用户的 Importing。

重要

补充:也就是说,ChatGPT API 的提示是“消息列表”组成的,不是纯字符串。因此每个消息是一个对象,有两个关键字段:

role:角色(告诉模型这句话是谁说的)content:具体内容(这句话的文本)

| 常见角色名 | 含义 | 示例用途 |

|---|---|---|

system | 系统提示,用来设定模型行为 | 您是一个乐于助人的编程助手。 |

user | 用户说的话 | 怎么用 Python 写个排序? |

assistant | AI 的回复 | 您可以用 sorted() 函数。 |

制作有效的提示既是一门艺术,也是一门科学。ChatGPT 专为人类对话而设计。这与使用 SQL 之类的东西来 ask a question(细致判断后的精确回答)完全不同。一个人必须与 AI 模型进行交流,类似于与另一个人交谈。正是这种交互方式的重要性,以至于 Prompt Engineering, 提示词工程 一词已经成为一门独立的学科。有一系列新兴的技术可以提高提示的有效性。投入时间制作提示可以大大提高结果输出。

分享提示已成为一种公共实践,并且正在积极地进行关于这一主题的学术研究。例如,创建有效的提示(例如,与 SQL 形成对比)是多么违反直觉,最近的一篇研究论文 发现,您可以使用的最有效的提示之一以短语“深呼吸并逐步完成此工作”开头。这应该可以告诉您为什么语言如此重要。我们还不完全了解如何最有效地利用这项技术的先前迭代,例如 ChatGPT 3.5,更不用说正在开发的新版本了。

创建有效的提示包括建立请求的上下文,并将请求的各个部分替换为特定于用户输入的值。此过程使用传统的基于文本的模板引擎进行提示创建和管理。Spring AI 为此使用了 OSS 库 StringTemplate。例如,考虑简单的提示模板:

Tell me a {adjective} joke about {content}.

Copied!在 Spring AI 中,提示模板可以比作 Spring MVC 架构中的 “视图”。提供模型对象(通常是 java.util.Map)来填充模板中的占位符。提示模板加数据模型合成的 rendered 最终字符串成为提供给 AI 模型的提示的内容。

不过就像之前说的提示的文本不再是单纯的消息字符串,也可能是消息对象,现在发送到模型的提示的特定数据格式存在相当大的变化。提示最初从简单字符串开始,现在已经发展到包含多条消息,其中每条消息中的每个字符串代表模型的不同角色。

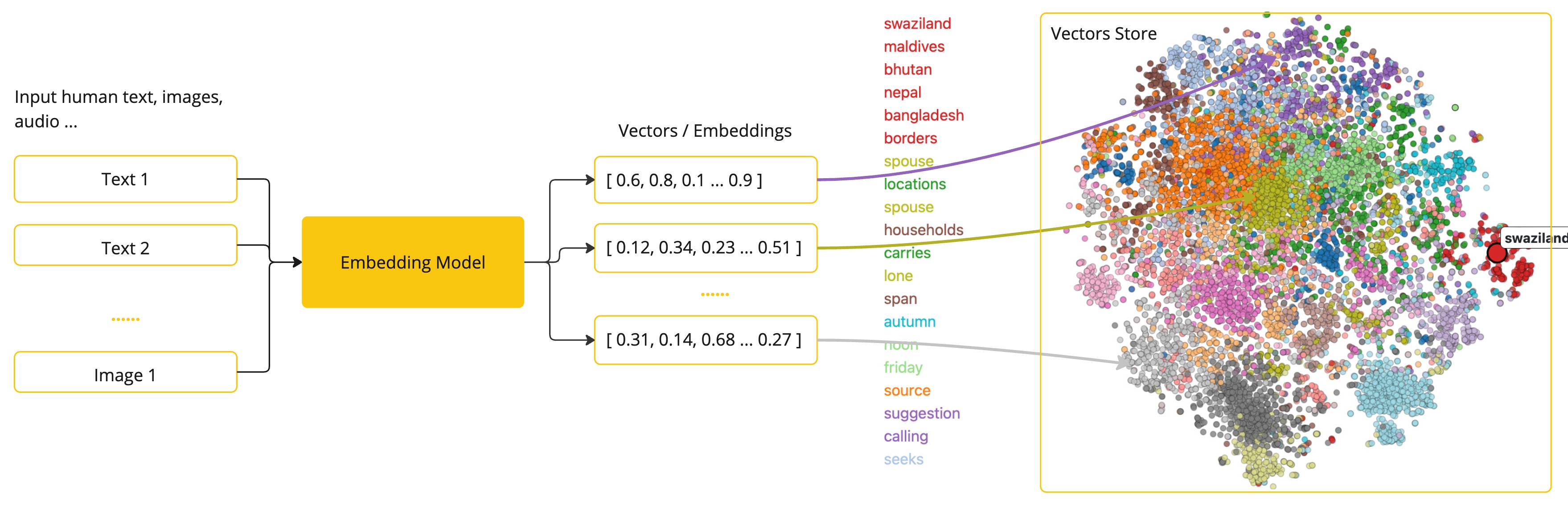

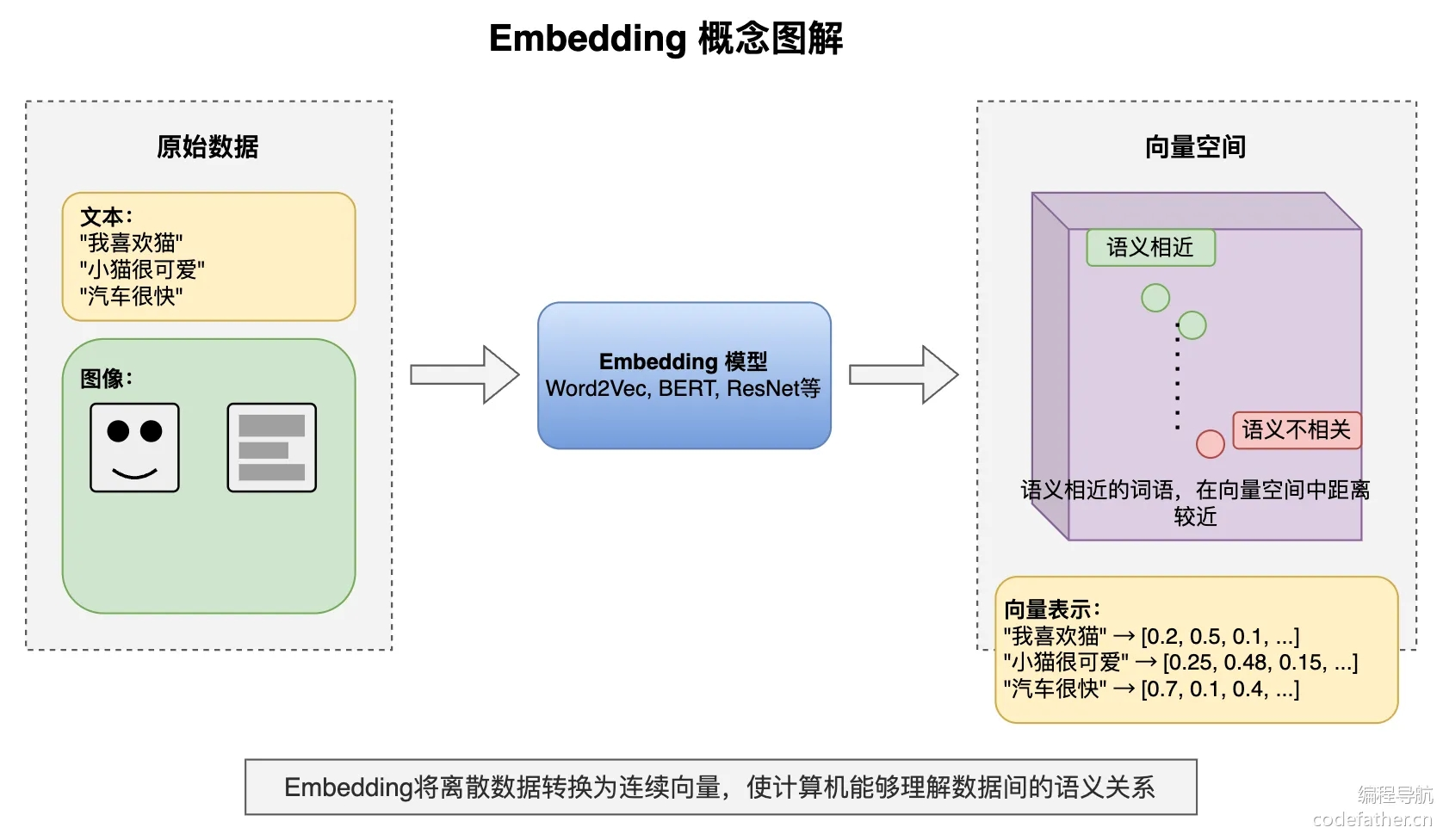

3.1.3.嵌入

这里的嵌入就是指 文本、图像、视频 的数字表示形式,用于捕获输入之间的关系(人话就是对比两个输入之前的关系,比如相似度)。嵌入的工作原理是将文本、图像、视频转换为浮点数数组(称为向量)。这些矢量旨在捕获文本、图像、视频的含义。嵌入数组的长度称为向量的维数。通过计算两段文本的向量表示之间的数值距离,应用程序可以确定用于生成嵌入向量的对象之间的相似性。

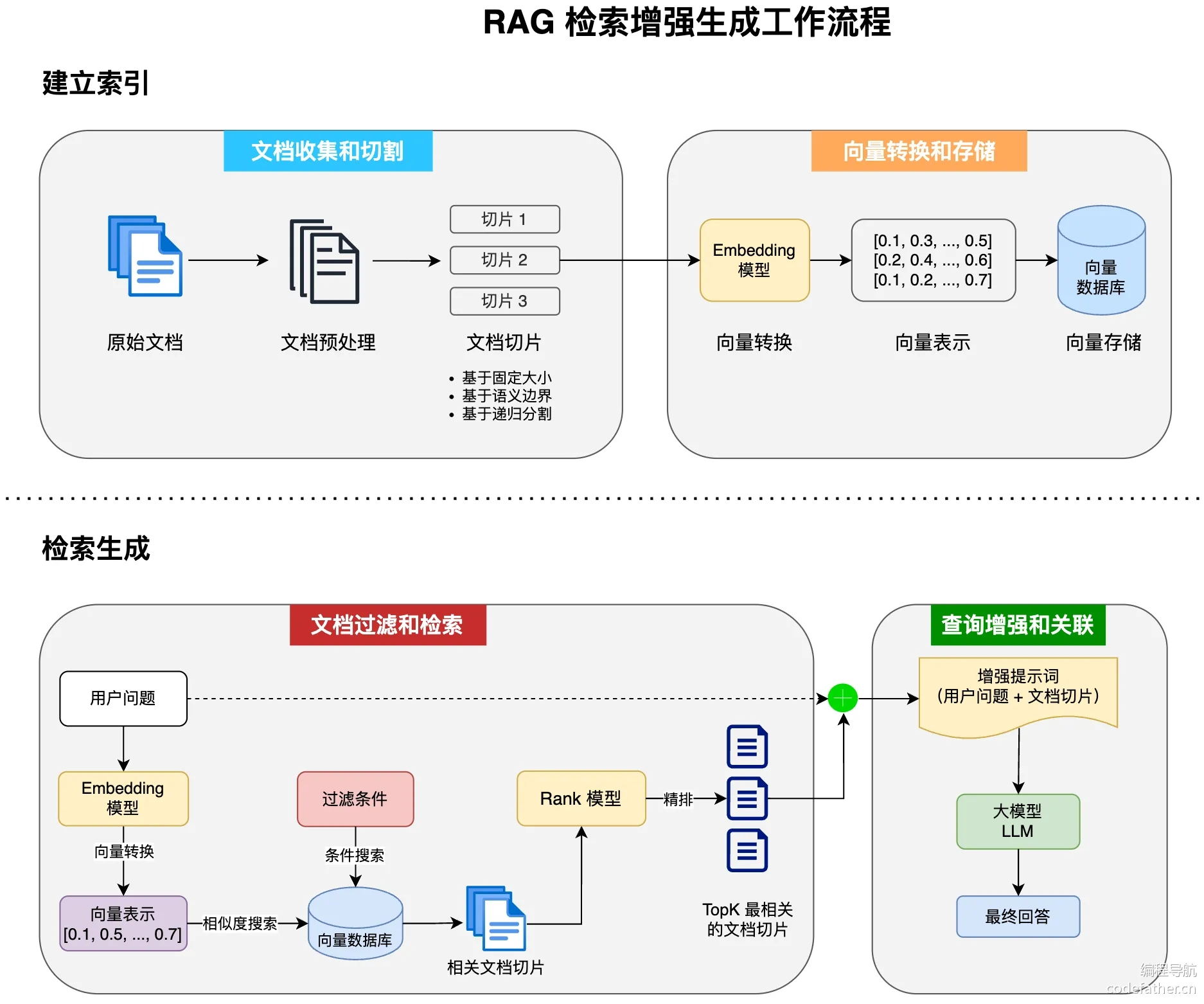

嵌入在 RAG, Retrieval Augmented Generation, 检索增强生成 模式等实际应用中尤其相关。它们能够将数据表示为语义空间中的点,这类似于欧几里得几何的二维空间,但维度更高。这意味着就像欧几里得几何中平面上的点可以根据其坐标来接近或远一样,在语义空间中,点的接近反映了含义的相似性。在这个多维空间中,关于相似主题的句子被放置在更近的位置,就像图表上彼此靠近的点一样。这种接近有助于文本分类、语义搜索甚至产品推荐等任务,因为它允许 AI 根据相关概念在这个扩展的语义环境中的 “位置” 来识别和分组。

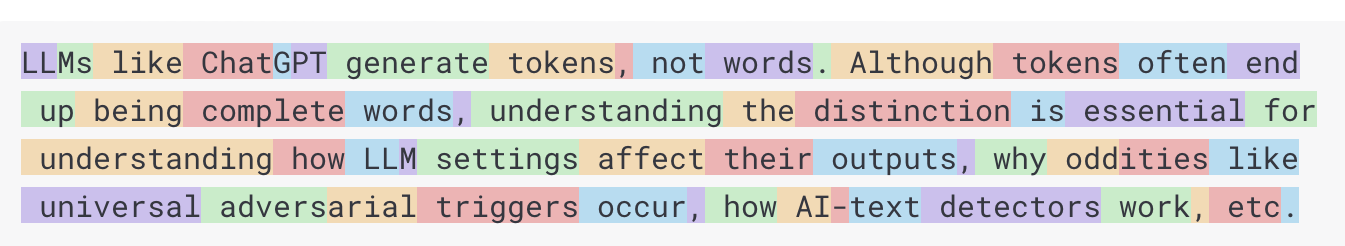

3.1.4.令牌

Token 是 AI 模型工作原理的构建块(其实就是处理时的基本元素)。在输入时,模型将单词转换为 Token。在输出时,他们将 Token 转换回单词。在英语中,一个标记大约相当于一个单词的 75%。作为参考,莎士比亚全集总计约 900,000 字,翻译成大约 120 万个代币。

通常在一些 AI 厂家中,您的费用由使用的令牌数量决定,输入和输出都会影响总令牌计数。此外,模型还受令牌限制的约束,这些限制限制了在单个 API 调用中处理的文本量。此阈值通常称为 上下文窗口。模型不会处理任何超过此限制的文本。例如,ChatGPT3 有 4K 限制,而 GPT4 提供不同的选项,例如 8K、16K、32K。Anthropic 的 Claude AI 模型具有 100K 限制,而 Meta 最近的研究产生了 1M 限制模型。

要使用 GPT4 总结莎士比亚的收藏作品,您需要制定软件工程策略来切碎数据并在模型的上下文窗口限制内呈现数据。Spring AI 项目可帮助您完成此任务。

3.1.5.结构化输出

在语言模型中,有一个麻烦的问题,无论您让模型返回什么格式(比如 JSON),它本质上返回的始终是 String,即文本,不是程序中的“JSON 对象”或“Map”。它只是看起来像 JSON 的字符串,您还需要手动再 parse, 解析 一次,才能变成可操作的数据结构。比如 “请以 JSON 格式回答” ≠ 保证一定是 JSON,这原因也有很多个:

- 模型可能输出不完整的

JSON(少了大括号) - 有时候还会额外加说明文字

- ...

这些模型本质是“语言模型”,是根据词来预测的,没真正理解数据结构。这种复杂性导致了一个专业领域的出现,该领域涉及创建提示以产生预期的输出,然后将生成的简单字符串转换为可用于应用程序集成的数据结构。

3.1.6.自定义模型

如何为 AI 模型配备尚未训练的信息?请注意,GPT 3.5/4.0 数据集仅延长至 2021 年 9 月。因此,该模型表示它不知道该日期之后问题的答案。一个有趣的琐事是,这个数据集大约有 650GB。有三种技术可用于自定义 AI 模型以合并您的实时数据:

- 参数微调:本质是改模型本身,把它“重新训练”成您的私有模型。就像拿一个

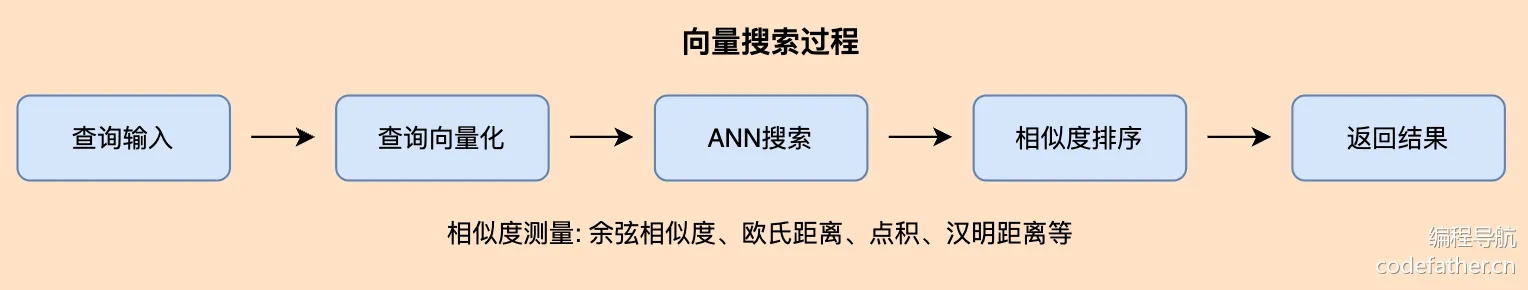

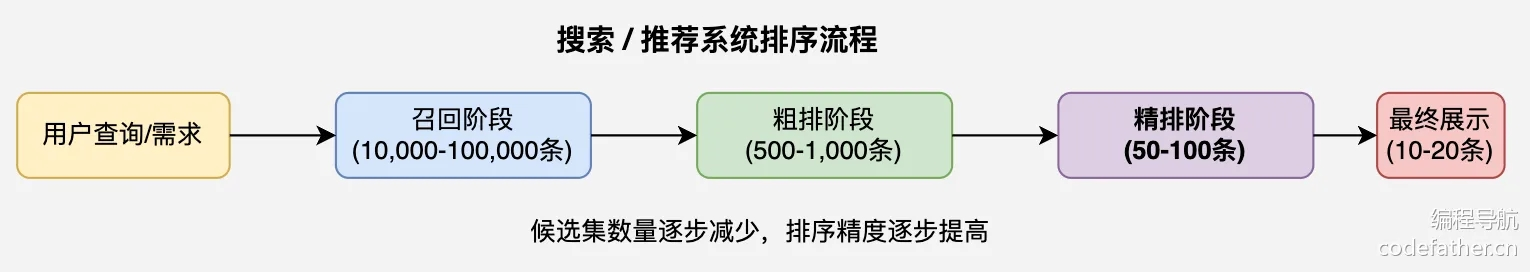

GPT模型,然后继续训练它,让它学会您自己的数据。不过这会直接修改模型内部的权重参数,非常消耗GPU,并且专业性非常强,工程复杂。 - 提示填充:不改模型,而是“骗它”在对话中去理解您的数据。您把自己的知识,作为提示词拼进去。这样模型不需要训练,它只是临时参考上下文。而加强的方案就是检索增强,也就是之前提到的

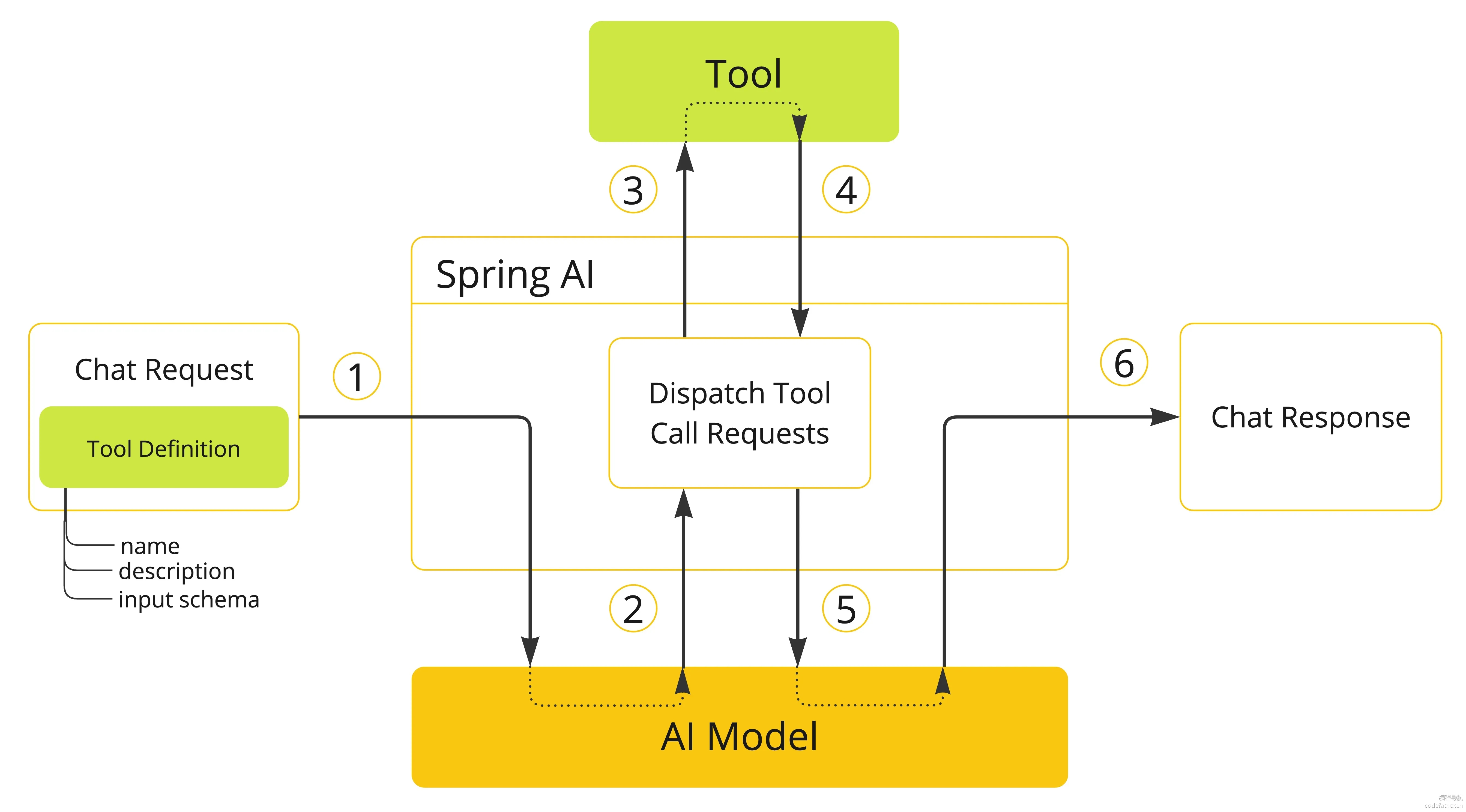

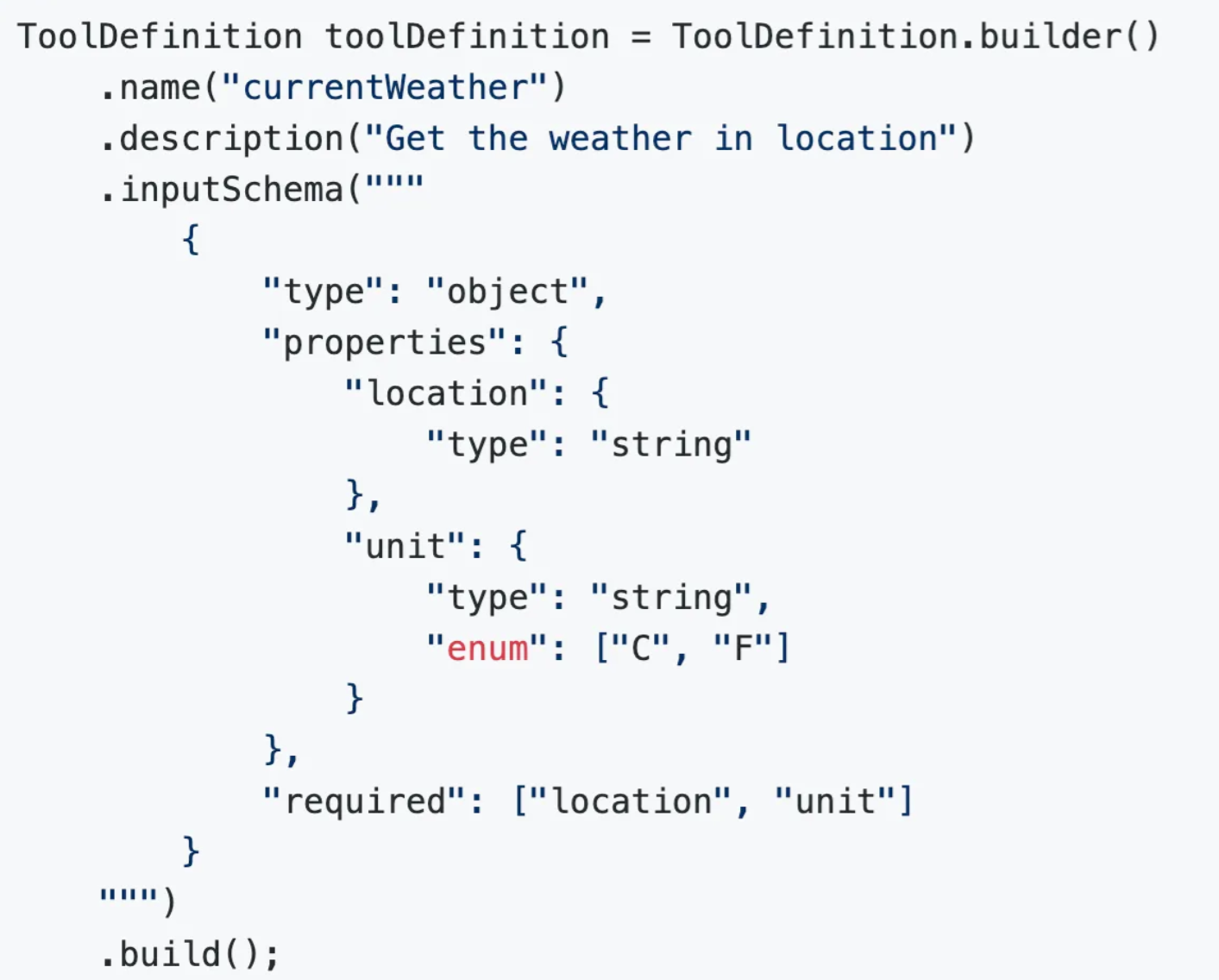

RAG,把您的资料(PDF、文档、网页、代码)提前整理好后,存到向量数据库里,当用户提问时,找出“相关资料片段”,再和问题一起塞给大语言模型回答。而之所以使用向量数据库,是因为我们可以利用RAG模糊找出相关的矢量,而不是使用普通数据库的精确查询 - 工具调用:该技术允许注册将大型语言模型连接到外部系统

API的工具(用户定义的服务)。Spring AI大大简化了您需要编写以支持工具调用的代码。

3.1.7.评估回答效果

想知道 AI 回答得靠不靠谱?就得对它的回答进行“评估”,而 Spring AI 提供了对应的 API 工具来帮您这么做。此评估过程包括分析生成的响应是否与用户的意图和查询的上下文一致。相关性、连贯性和事实正确性等指标用于衡量 AI 生成的响应的质量。一种方法是把 用户问题 + AI 回答 再交给 AI 来判断对不对,也就是自己批判自己。

3.1.8.智能体

这里简单描述一些关于智能体的知识,如果您需要了解如何实现一个智能体,可以翻阅我的个人主页来查看具体的开发过程。

3.1.8.1.大致分类

反应式智能体:仅根据当前输入和固定规则做出反应,类似简单的聊天机器人,没有真正的规划能力,

23年时的大多数AI聊天机器人应用,几乎都是反应式智能体有限规划智能体:能进行简单地多步骤执行,但执行路径通常是预设的或有严格限制的。鉴定为 “能干事、但干不了复杂的大事”。

24年流行的很多可联网搜索内容、调用知识库和工具的AI应用,都属于这类智能体,比如ChatGPT + Plugins的模式自主规划智能体:也叫目标导向智能体,能够根据任务目标自主分解任务、制定计划、选择工具并一步步执行,直到完成任务。比如

25年初很火的Manus项目,它的核心亮点在于其 “自主执行” 能力。据官方介绍,Manus能够在虚拟机中调用各种工具(如编写代码、爬取数据)完成任务。其应用场景覆盖旅行规划、股票分析、教育内容生成等40余个领域,所以在当时给了很多人震撼感。但其实早在这之前,就有类似的项目了,比如

AutoGPT,所以Manus大火的同时也被人诟病 “会营销而已”。甚至没隔多久就有小团队开源了Manus的复刻版 —— OpenManus,这类智能体通过 “思考-行动-观察” 的循环模式工作,能够持续推进任务直至完成目标。需要注意,自主规划能力是智能体发展的重要方向,但并非所有应用场景都需要完全的自主规划能力。在某些场景中,限制智能体的自主性反而能提高效率和安全性。

3.1.8.2.关键技术

3.1.8.2.1.CoT 思维链

CoT(Chain of Thought)思维链是一种让 AI 像人类一样 “思考” 的技术,帮助 AI 在处理复杂问题时能够按步骤思考。对于复杂的推理类问题,先思考后执行,效果往往更好。而且还可以让模型在生成答案时展示推理过程,便于我们理解和优化 AI。

CoT 的实现方式其实很简单,可以在输入 Prompt 时,给模型提供额外的提示或引导,比如 “让我们一步一步思考这个问题”,让模型以逐步推理的方式生成回答。还可以运用 Prompt 的优化技巧 few shot,给模型提供包含思维链的示例问题和答案,让模型学习如何构建自己的思维链。

在 OpenManus 早期版本中,可以看到实现 CoT 的系统提示词(翻译后的版本):

你是一个专注于思维链推理的助手。对于每个问题,请遵循以下步骤:

1. 分解问题:把复杂的问题分成更小、更容易处理的部分

2. 一步一步思考:仔细思考每个部分,展示你的推理过程

3. 综合结论:将每个部分的思考整合成一个完整的解决方案

4. 给出一个答案:给出一个最终的简明答案

您的回复应遵循以下格式:

思考:[详细的思考过程,包括问题分解、每个步骤的推理和分析]

答案:【最终答案基于思考过程,清晰简洁】

记住,思考过程比最终的答案更重要,因为它展示了你是如何得出结论的。3.1.8.2.2.Agent Loop 执行循环

Agent Loop 是智能体最核心的工作机制,指智能体在没有用户输入的情况下,自主重复执行推理和工具调用的过程。

在传统的聊天模型中,每次用户提问后,AI 回复一次就结束了。但在智能体中,AI 回复后可能会继续自主执行后续动作(如调用工具、处理结果、继续推理),形成一个自主执行的循环,直到任务完成(或者超出预设的最大步骤数)。

参考下面的伪代码实现:

public String execute() {

List<String> results = new ArrayList<>();

while (currentStep < MAX_STEPS && !isFinished) {

currentStep++;

// 这里实现具体的步骤逻辑

String stepResult = executeStep();

results.add("步骤 " + currentStep + ": " + stepResult);

}

if (currentStep >= MAX_STEPS) {

results.add("达到最大步骤数: " + MAX_STEPS);

}

return String.join("\n", results);

}3.1.8.2.3.ReAct 模式

ReAct(Reasoning + Acting)是一种结合推理和行动的智能体架构,它模仿人类解决问题时 ”思考 - 行动 - 观察” 的循环,目的是通过交互式决策解决复杂任务,是目前最常用的智能体工作模式之一。

核心思想:

- 推理(

Reason):将原始问题拆分为多步骤任务,明确当前要执行的步骤,比如 “第一步需要打开网站” - 行动(

Act):调用外部工具执行动作,比如调用搜索引擎、打开浏览器访问网页等 - 观察(

Observe):获取工具返回的结果,反馈给智能体进行下一步决策。比如将打开的网页代码输入给AI - 循环(

While):不断重复上述3个过程,直到任务完成或达到终止条件

可以参考伪代码实现:

void executeReAct(String task) {

String state = "开始";

while (!state.equals("完成")) {

// 1. 推理 (Reason)

String thought = "思考下一步行动";

System.out.println("推理: " + thought);

// 2. 行动 (Act)

String action = "执行具体操作";

System.out.println("行动: " + action);

// 3. 观察 (Observe)

String observation = "观察执行结果";

System.out.println("观察: " + observation);

// 更新状态

state = "完成";

}

}重要

补充:这种模式其实就结合了前面的两种模式。

3.1.8.2.4.其他重要技术

除了基本的工作机制外,智能体的实现还依赖于很多支持系统。

AI大模型本身,这个就不多说了,大模型提供了思考、推理和决策的核心能力,越强的AI大模型通常执行任务的效果越好- 记忆系统:智能体需要记忆系统来存储对话历史、中间结果和执行状态,这样它才能够进行连续对话并根据历史对话分析接下来的工作步骤。之前我们学习过如何使用

Spring AI的ChatMemory实现对话记忆 - 知识库:尽管大语言模型拥有丰富的参数知识,但针对特定领域的专业知识往往需要额外的知识库支持。之前我们学习过,通过

RAG检索增强生成 + 向量数据库等技术,智能体可以检索并利用专业知识回答问题 - 工具调用:工具是扩展智能体能力边界的关键,智能体通过工具调用可以访问搜索引擎、数据库、

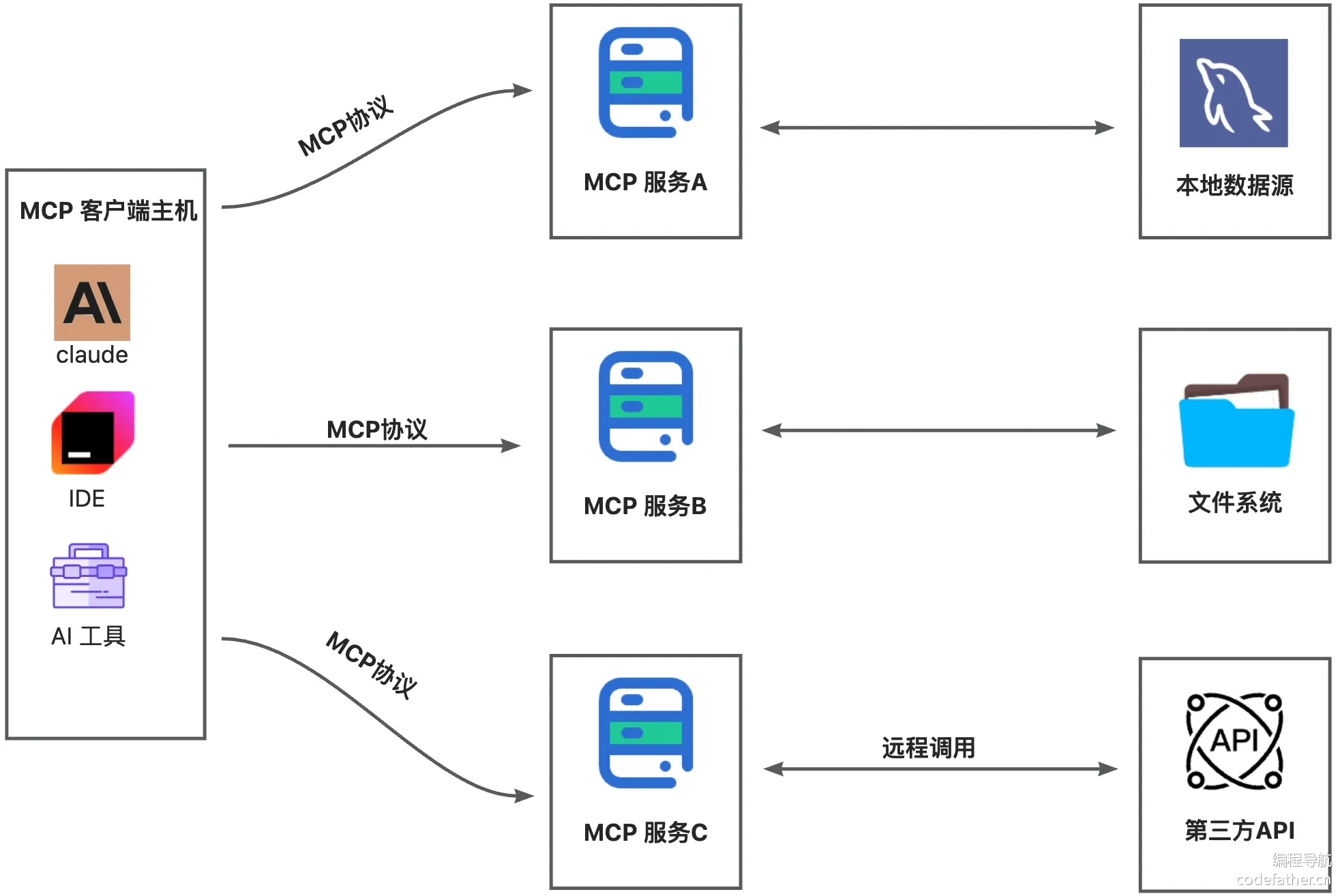

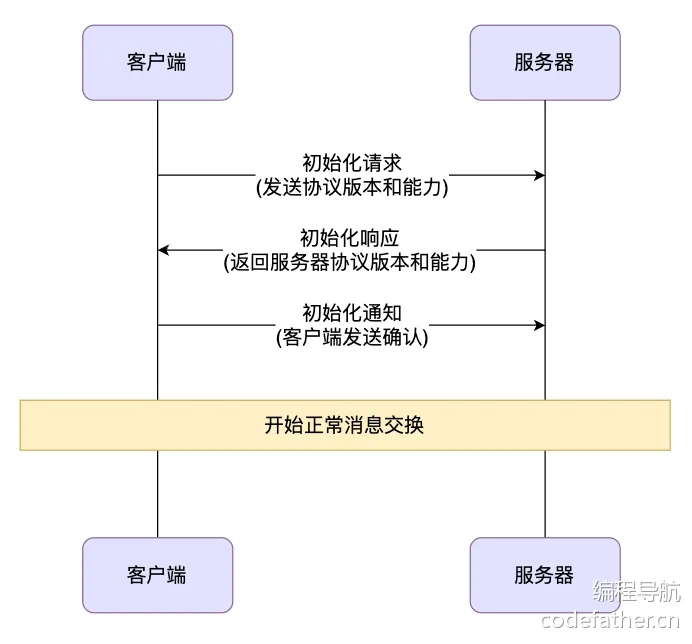

API接口等外部服务,极大地增强了其解决实际问题的能力。当然,MCP也可以算是工具调用的一种。

重要

补充:“其他重要技术”其实反倒在本篇文档中重点进行讲解。

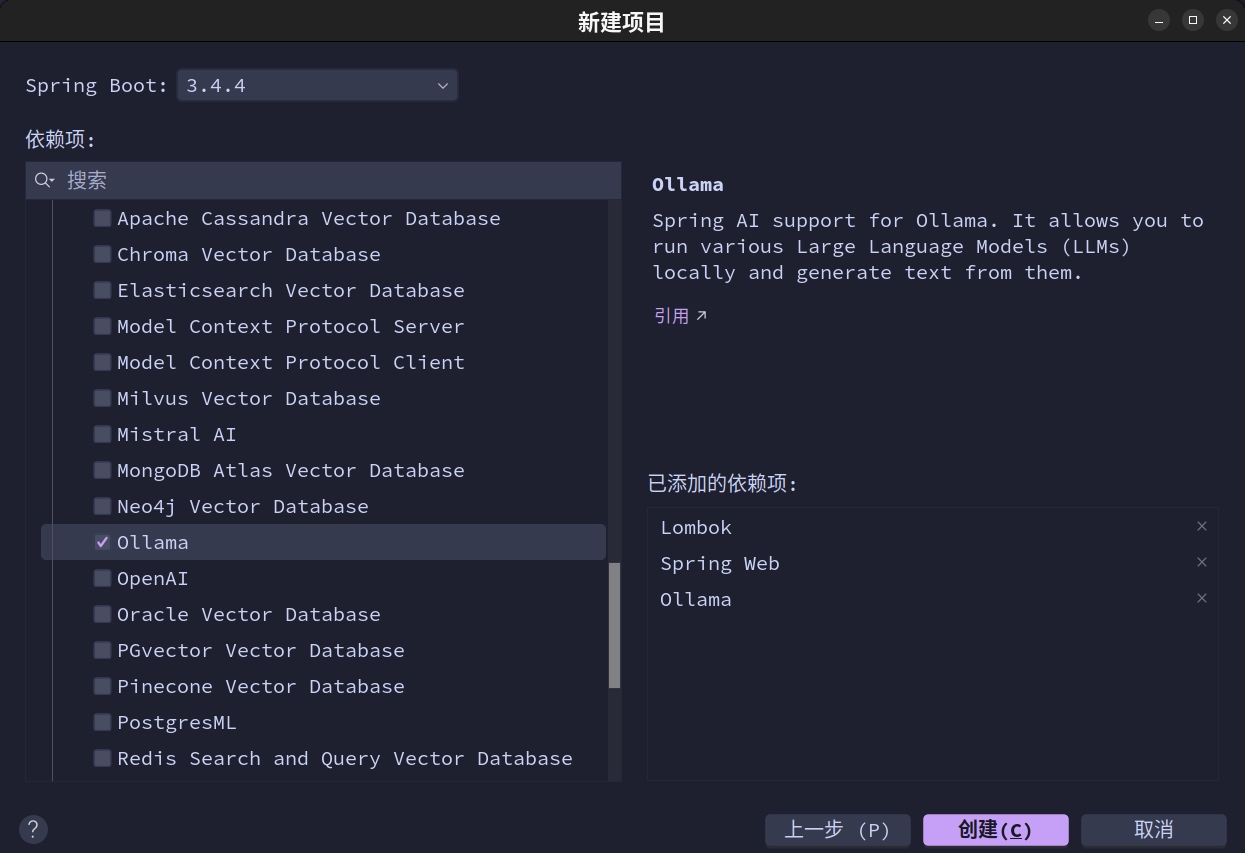

3.2.依赖安装

Spring AI 的核心依赖分为里程版本和快照版本,这里我们采用更加稳定的里程版本。并且建立项目最好使用 Java21 + Spring Boot3.4.4,这是官方文档中(2025.04.22)提到的版本,我接下来的测试也会使用这个版本。

我们直接使用 IDEA 默认提供的就可以,不用自己再引入依赖了。

我把我的依赖交给您阅读,您可以查阅一下。

<?xml version="1.0" encoding="UTF-8"?>

<project xmlns="http://maven.apache.org/POM/4.0.0" xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 https://maven.apache.org/xsd/maven-4.0.0.xsd">

<!-- 元数描述 -->

<modelVersion>4.0.0</modelVersion>

<packaging>jar</packaging>

<name>work-multilingual-ai</name>

<description>work-multilingual-ai</description>

<url>https://github.com/limou3434</url>

<licenses>

<license>

<name>MIT License</name>

<url>https://opensource.org/licenses/MIT</url>

<distribution>repo</distribution>

</license>

</licenses>

<!-- 标识描述 -->

<groupId>cn.com.edtechhub</groupId>

<artifactId>work-multilingual-ai</artifactId>

<version>0.0.1</version>

<!-- 版本描述 -->

<properties>

<java.version>21</java.version>

<spring-ai.version>1.0.0-M7</spring-ai.version>

</properties>

<!-- 继承描述 -->

<parent>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-parent</artifactId>

<version>3.4.4</version>

<relativePath/>

</parent>

<!-- 依赖描述 -->

<dependencyManagement>

<dependencies>

<dependency>

<groupId>org.springframework.ai</groupId>

<artifactId>spring-ai-bom</artifactId>

<version>${spring-ai.version}</version>

<type>pom</type>

<scope>import</scope>

</dependency>

</dependencies>

</dependencyManagement>

<dependencies>

<!-- Spring: https://spring.io/ -->

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-web</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.ai</groupId>

<artifactId>spring-ai-starter-model-ollama</artifactId>

</dependency>

<!-- Lombok: https://projectlombok.org/ -->

<dependency>

<groupId>org.projectlombok</groupId>

<artifactId>lombok</artifactId>

<optional>true</optional>

</dependency>

</dependencies>

<!-- 插件描述 -->

<build>

<plugins>

<plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-compiler-plugin</artifactId>

<configuration>

<annotationProcessorPaths>

<path>

<groupId>org.projectlombok</groupId>

<artifactId>lombok</artifactId>

</path>

</annotationProcessorPaths>

</configuration>

</plugin>

<plugin>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-maven-plugin</artifactId>

<configuration>

<excludes>

<exclude>

<groupId>org.projectlombok</groupId>

<artifactId>lombok</artifactId>

</exclude>

</excludes>

</configuration>

</plugin>

</plugins>

</build>

</project>这里稍微解释一下,官方文档说有两种版本,一种是里程版本、一种是快照版本,这里我们延用 IDEA 给我们的版本就可以。

3.3.入门学习

接下来我开始围绕 Spring AI 提供的通信对象讲解相关的内容。

3.3.1.单个模型

在我们的 Spring AI 中有一个类 ChatClient,用于提供与 AI 模型通信的 Fluent API,它支持:

- 同步编程模型:您发一个消息,等

AI回复 - 流式编程模型:

AI边生成边返回,比如OpenAI的流式回复一样

重要

补充:Fluent API 是一种编程风格(不是框架、不是库),它通过方法链式调用来实现更可读、流畅、自然语言化的配置或构建逻辑。

该 Fluent API 具有构建提示词组成部分的方法 prompt(),后续链式调用的部分作为输入传递给 AI 模型。AI 模型处理两种主要类型的消息:

- 系统消息(由系统生成以指导对话)

- 用户消息(来自用户的直接输入)

这些消息通常包含占位符,这些占位符在运行时根据用户输入进行替换,以自定义 AI 模型对用户输入的响应。除了构建提示词内容外,还可以设置一些额外选项,例如模型名字、温度(随机性和创造性)等。

ChatClient 是使用 ChatClient.Builder 对象创建的。您可以把任何 ChatModel 接入 Spring Boot 中(本教程我们使用 Ollama),将获取自动配置的 ChatClient.Builder 实例,或者以编程方式创建一个实例。在最简单的用例中,创建一个原型 ChatClient.Builder bean 供您注入到您的类中,下面是检索对简单用户请求的 String 响应的简单示例。

这里我们开始我们第一次的实践,我决定使用 Spring AI + Ollama 并且拉取语言模型开始,无他因为更好入门。在上面其实我们就接入了模型依赖,在引入 Spring AI 后引入了支持 Ollama 的依赖。

<dependency>

<groupId>org.springframework.ai</groupId>

<artifactId>spring-ai-starter-model-ollama</artifactId>

</dependency>然后我们需要部署一下 Ollama,这在之前的章节中提到过,这里留个 部署链接 给您即可,个人推荐使用 Docker 进行部署,并且推荐在 Docker 中使用宿主的 GPU 资源,并且一定要部署到 http://127.0.0.1:11434 中,同时在容器内部运行 ollama run llama3.2 拉取并运行模型。

然后配置我们的应用配置文件,简单配置一下就可以。

# 配置框架(使用 java -jar app.jar --spring.profiles.active=develop | release | production 来启动项目, 其中 release 有时间就拿来测试, 而 production 存储在 Github 上, 每次修改 Github 配置就需要刷新(这个有时间可以优化为无需重启))

spring:

## 配置环境

profiles:

active: ${SPRING_PROFILES_ACTIVE:develop} # 默认启动开发环境

## 配置名称

application:

name: work-multilingual-ai

## 配置智能

ai:

ollama:

base-url: http://127.0.0.1:11434

chat:

model: llama3.2 # DeepSeek-R1

# 配置服务

server:

## 项目名称

project-name: work-multilingual-ai

## 配置地址

address: 127.0.0.1

## 配置端口

port: 8000

## 配置路由

servlet:

context-path: /work_multilingual_ai_api # 这样所有接口都会带上前缀package cn.com.edtechhub.workmultilingualai;

import org.springframework.ai.chat.client.ChatClient;

import org.springframework.web.bind.annotation.GetMapping;

import org.springframework.web.bind.annotation.RequestParam;

import org.springframework.web.bind.annotation.RestController;

import java.util.Map;

@RestController

public class ChatController {

private final ChatClient chatClient;

public ChatController(ChatClient.Builder chatClientBuilder) {

this.chatClient = chatClientBuilder.build(); // 这里自动加载了我们配置文件中写的模型类型

}

@GetMapping("/ai/generate")

public Map<String, String> generate(@RequestParam(value = "message", defaultValue = "您是谁") String message) {

String result = chatClient.prompt() // 开始链式构造提示词

.user(message) // 用户消息

.call() // 向 AI 模型发送请求

.content() // 将 AI 模型的响应作为 String 返回

;

if (result != null) {

return Map.of("generation", result);

}

return Map.of();

}

}重要

补充:如果您希望手动加载多种不同的模型,则可以使用 spring.ai.chat.client.enabled:false 关掉自动导入,然后在对应 Ollama 中拉取不同的模型,再参考 文档 1 和 文档 2 进行手动配置。

首先 文档1 说明了想要手动导入需要编写以下代码:

ChatModel myChatModel = /*...*/;

ChatClient.Builder builder = ChatClient.builder(this.myChatModel);

ChatClient chatClient = ChatClient.create(this.myChatModel);其实目的就是把我们的 chatClient 使用别的构造函数来手动构造。再根据 文档2 提供关于 ollama 的 ChatModel 构造过程。

var ollamaApi = new OllamaApi(); // 默认的请求地址就是 http://127.0.0.1:11434, 如果您的 ollama 部署在这个地址可以不用更换

var chatModel = OllamaChatModel.builder()

.ollamaApi(ollamaApi)

.defaultOptions(

OllamaOptions.builder()

.model(OllamaModel.MISTRAL) // 选择模型的地方, 可以自己重载枚举体, 也可以使用字符常量

.temperature(0.9)

.build())

.build();就可以手动来进行导入了。

package cn.com.edtechhub.workmultilingualai;

import org.springframework.ai.chat.client.ChatClient;

import org.springframework.ai.chat.model.ChatModel;

import org.springframework.ai.ollama.OllamaChatModel;

import org.springframework.ai.ollama.api.OllamaApi;

import org.springframework.ai.ollama.api.OllamaOptions;

import org.springframework.web.bind.annotation.GetMapping;

import org.springframework.web.bind.annotation.RequestParam;

import org.springframework.web.bind.annotation.RestController;

import java.util.Map;

@RestController

public class ChatController {

OllamaApi ollamaApi = new OllamaApi("http://127.0.0.1:11434");

ChatModel myChatModel = OllamaChatModel

.builder()

.ollamaApi(ollamaApi)

.defaultOptions(

OllamaOptions

.builder()

.model("DeepSeek-R1")

.temperature(0.9)

.build())

.build();

ChatClient.Builder builder = ChatClient.builder(this.myChatModel);

ChatClient chatClient = ChatClient.create(this.myChatModel);

// private final ChatClient chatClient;

// public ChatController(ChatClient.Builder chatClientBuilder) {

// this.chatClient = chatClientBuilder.build(); // 这里自动加载了我们配置文件中写的模型类型

// }

@GetMapping("/ai/generate")

public Map<String, String> generate(@RequestParam(value = "message", defaultValue = "您是谁") String message) {

String result = chatClient.prompt() // 开始链式构造提示词

.user(message) // 用户消息

.call() // 向 AI 模型发送请求

.content() // 将 AI 模型的响应作为 String 返回

;

if (result != null) {

return Map.of("generation", result);

}

return Map.of();

}

}3.3.2.多个模型

由于我自己的项目需要支持多个模型,因此我这里稍微封装一下代码。

<?xml version="1.0" encoding="UTF-8"?>

<project xmlns="http://maven.apache.org/POM/4.0.0" xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 https://maven.apache.org/xsd/maven-4.0.0.xsd">

<!-- 元数描述 -->

<modelVersion>4.0.0</modelVersion>

<packaging>jar</packaging>

<name>work-multilingual-ai</name>

<description>work-multilingual-ai</description>

<url>https://github.com/limou3434</url>

<licenses>

<license>

<name>MIT License</name>

<url>https://opensource.org/licenses/MIT</url>

<distribution>repo</distribution>

</license>

</licenses>

<!-- 标识描述 -->

<groupId>cn.com.edtechhub</groupId>

<artifactId>work-multilingual-ai</artifactId>

<version>0.0.1</version>

<!-- 版本描述 -->

<properties>

<java.version>21</java.version>

<spring-ai.version>1.0.0-M7</spring-ai.version>

</properties>

<!-- 继承描述 -->

<parent>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-parent</artifactId>

<version>3.4.4</version>

<relativePath/>

</parent>

<!-- 依赖描述 -->

<dependencyManagement>

<dependencies>

<dependency>

<groupId>org.springframework.ai</groupId>

<artifactId>spring-ai-bom</artifactId>

<version>${spring-ai.version}</version>

<type>pom</type>

<scope>import</scope>

</dependency>

</dependencies>

</dependencyManagement>

<dependencies>

<!-- Spring: https://spring.io/ -->

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-web</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.ai</groupId>

<artifactId>spring-ai-starter-model-ollama</artifactId>

</dependency>

<!-- Lombok: https://projectlombok.org/ -->

<dependency>

<groupId>org.projectlombok</groupId>

<artifactId>lombok</artifactId>

<optional>true</optional>

</dependency>

</dependencies>

<!-- 插件描述 -->

<build>

<plugins>

<plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-compiler-plugin</artifactId>

<configuration>

<annotationProcessorPaths>

<path>

<groupId>org.projectlombok</groupId>

<artifactId>lombok</artifactId>

</path>

</annotationProcessorPaths>

</configuration>

</plugin>

<plugin>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-maven-plugin</artifactId>

<configuration>

<excludes>

<exclude>

<groupId>org.projectlombok</groupId>

<artifactId>lombok</artifactId>

</exclude>

</excludes>

</configuration>

</plugin>

</plugins>

</build>

</project># 配置框架(使用 java -jar app.jar --spring.profiles.active=develop | release | production 来启动项目, 其中 release 有时间就拿来测试, 而 production 存储在 Github 上, 每次修改 Github 配置就需要刷新(这个有时间可以优化为无需重启))

spring:

## 配置环境

profiles:

active: ${SPRING_PROFILES_ACTIVE:develop} # 默认启动开发环境

## 配置名称

application:

name: work-multilingual-ai

## 配置智能

ai:

chat:

client:

enabled: false # 是否允许自动导入模型

ollama:

base-url: http://127.0.0.1:11434 # ollama 部署地址

chat:

model: DeepSeek-R1 # ollama 默认自动导入的具体模型

# 配置服务

server:

## 项目名称

project-name: work-multilingual-ai

## 配置地址

address: 127.0.0.1

## 配置端口

port: 8000

## 配置路由

servlet:

context-path: /work_multilingual_ai_api # 这样所有接口都会带上前缀package cn.com.edtechhub.workmultilingualai;

import lombok.Data;

import org.springframework.ai.chat.client.ChatClient;

import org.springframework.ai.chat.model.ChatModel;

import org.springframework.ai.ollama.OllamaChatModel;

import org.springframework.ai.ollama.api.OllamaApi;

import org.springframework.ai.ollama.api.OllamaOptions;

import org.springframework.beans.factory.annotation.Value;

import org.springframework.web.bind.annotation.GetMapping;

import org.springframework.web.bind.annotation.RequestParam;

import org.springframework.web.bind.annotation.RestController;

import java.util.Map;

@Data

class ChatClientUtils {

/**

* 部署地址

*/

static private final String ollamaBaseUrl = "http://127.0.0.1:11434";

/**

* 模型种类

*/

static String models = "DeepSeek-R1";

/**

* 模型温度

*/

static double temperature = 0.8;

/**

* 创建客户对象

*/

static public ChatClient getChatClient() {

ChatModel chatModel = OllamaChatModel // 构建模型

.builder()

.ollamaApi(new OllamaApi(ollamaBaseUrl))

.defaultOptions(

OllamaOptions

.builder()

.model(models)

.temperature(temperature)

.build())

.build();

ChatClient.Builder builder = ChatClient.builder(chatModel); // 这句先保留

return ChatClient.create(chatModel); // 客户对象

}

}

@RestController

public class ChatController {

private final ChatClient chatClient = ChatClientUtils.getChatClient();

@GetMapping("/ai/generate")

public String generate(@RequestParam(value = "message", defaultValue = "您是谁") String message) {

return chatClient.prompt() // 开始链式构造提示词

.user(message) // 用户消息

.call() // 向 AI 模型发送请求

.content();

}

}这样我只需要使用 geter/seter 就可以自由调配我的模型以及相关参数。

3.3.3.获取令牌

ChatClient 提供 chatResponse() 以获取详细的 token 等重要信息,在上述代码控制类中添加下面的新方法。

@GetMapping("/ai/chat_response")

public ChatResponse chatResponse(@RequestParam(value = "message", defaultValue = "您知道米哈游么?") String message) {

return chatClient.prompt() // 开始链式构造提示词

.user(message) // 用户消息

.call() // 向 AI 模型发送请求

.chatResponse(); // 内部包含 token

}3.3.4.结构输出

ChatClient 提供 entity() 运行响应字符映射到实体中,虽然 Spring AI 支持您这么做,但需要模型本身支持...

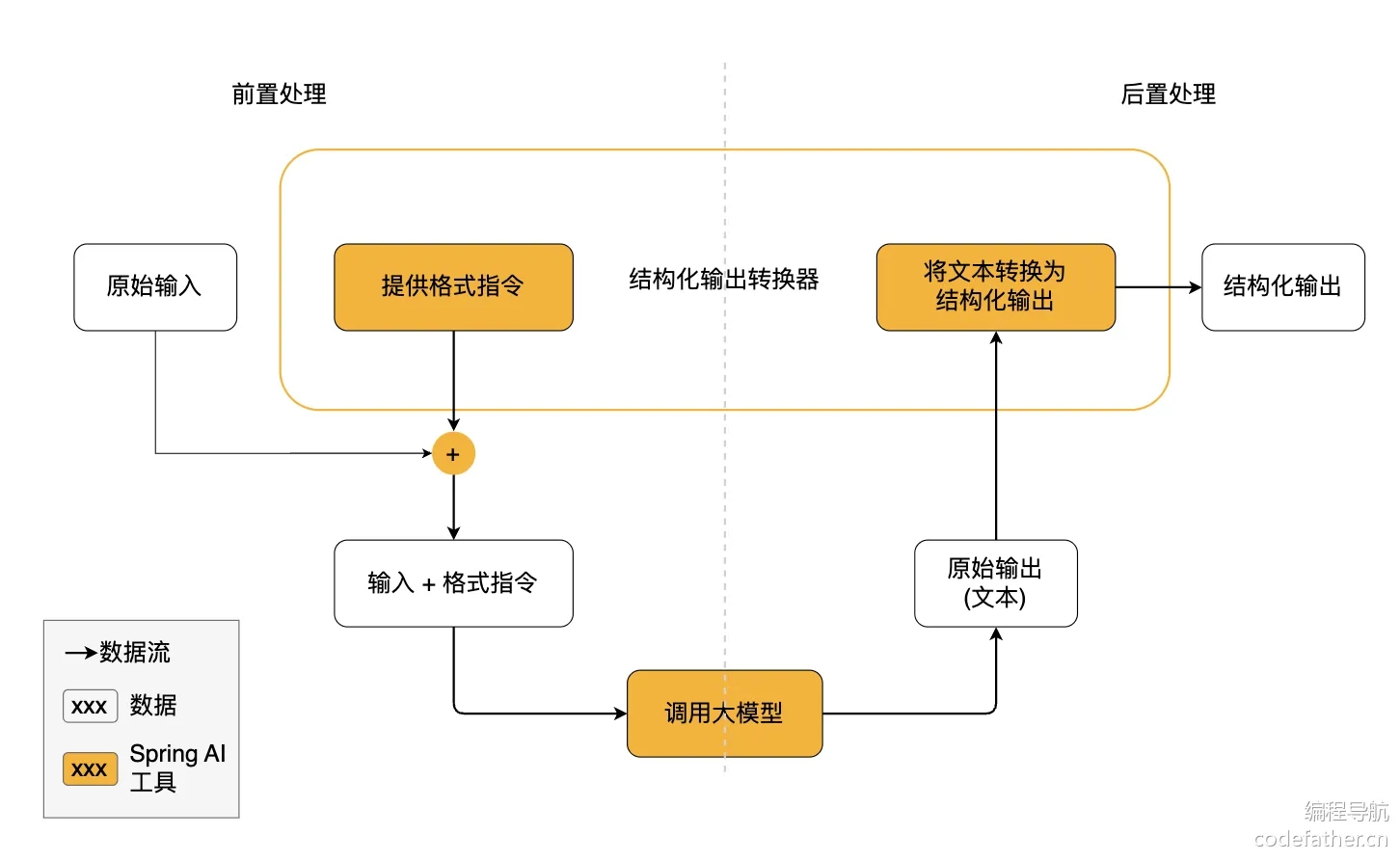

结构化输出转换器在大模型调用前后都发挥作用:

- 调用前:转换器会在提示词后面附加格式指令,明确告诉模型应该生成何种结构的输出,引导模型生成符合指定格式的响应

- 调用后:转换器将模型的文本输出转换为结构化类型的实例,比如将原始文本映射为

JSON、XML或其他特定数据结构

警告

警告:注意,结构化输出转换器只是 尽最大努力 将模型输出转换为结构化数据,AI 模型不保证一定按照要求返回结构化输出。有些模型可能无法理解提示词或无法按要求生成结构化输出。建议在程序中实现验证机制或者异常处理机制来确保模型输出符合预期。

public record ActorFilms(String actor, List<String> movies) {} // 只存数据的类, 存储作者和电影作品

@GetMapping("/ai/entity")

public ActorFilms entity(@RequestParam(value = "message", defaultValue = "成龙有哪些电影?") String message) {

return chatClient.prompt() // 开始链式构造提示词

.system("请您严格只用JSON格式回答,禁止输出任何解释、注释、额外内容,例如<think>标签、说明文字等。返回内容必须符合结构:{\"actor\": \"\", \"movies\": [\"\", \"\"]},也不准使用 markdown") // 系统消息

.user(message) // 用户消息

.call() // 向 AI 模型发送请求

.entity(ActorFilms.class); // Spring AI 结构化输出依赖模型自己是否支持严格 json, 当前的模型很难这么干...

}不过值得注意的是,只有部分模型是支持结构输出的,我测试了一下,您可以使用 mistral 来进行测试。

重要

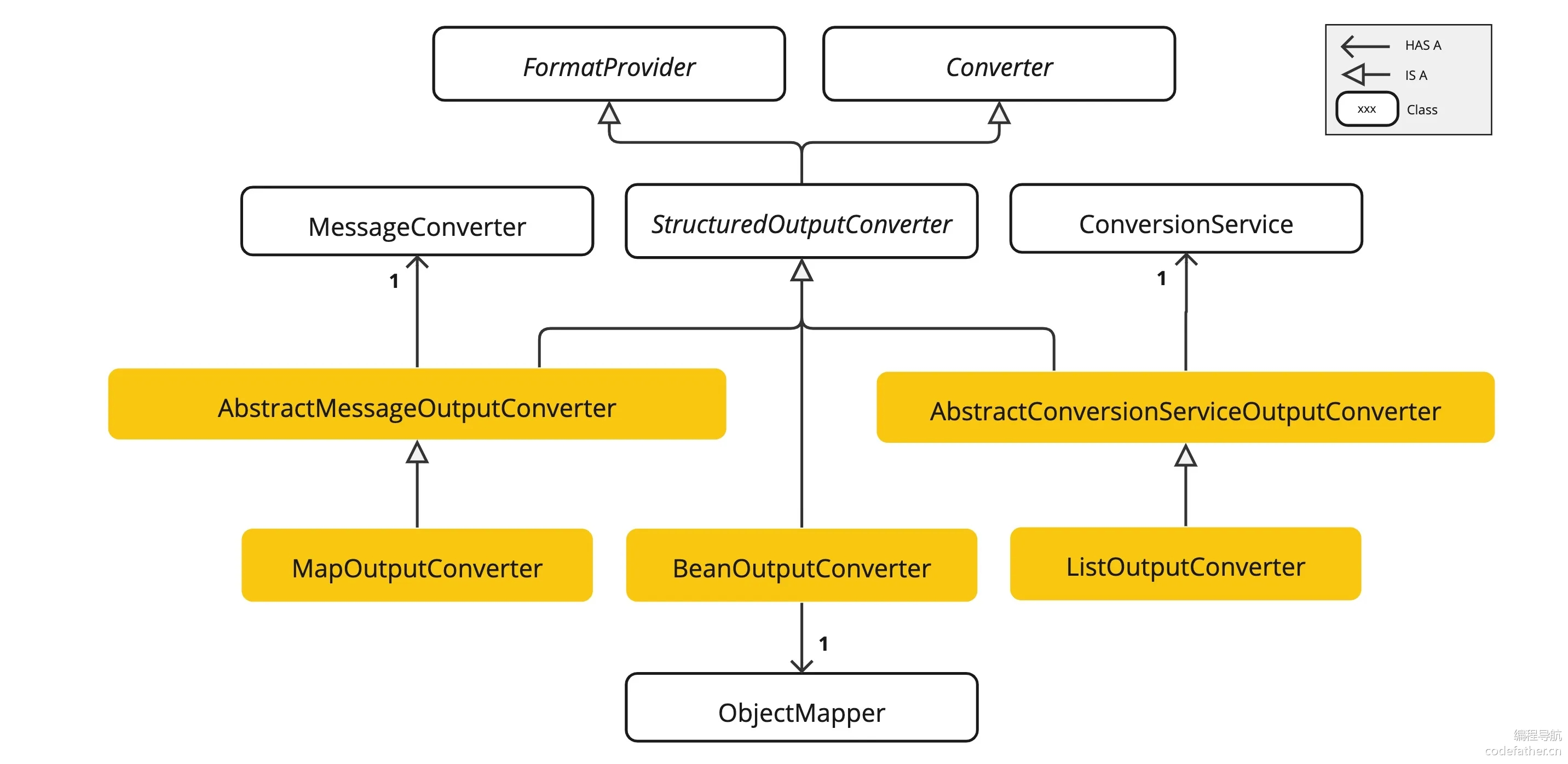

补充:不过这里的原理值得我们探究一下。结构化输出转换器 StructuredOutputConverter 接口允许开发者获取结构化输出,例如将输出映射到 Java 类或值数组。接口定义如下:

public interface StructuredOutputConverter<T> extends Converter<String, T>, FormatProvider {

... FormatProvider(...) // 该接口提供特定的 "格式指令" 传给 AI 模型

... Converter<String, T>(...) // 该接口负责将模型的文本输出转换为指定的目标类型 T

}而 Spring AI 根据这个接口声明实现了以下几种转化器:

AbstractConversionServiceOutputConverter:提供预配置的GenericConversionService,用于将LLM输出转换为所需格式AbstractMessageOutputConverter:支持Spring AI Message的转换BeanOutputConverter:用于将输出转换为Java Bean对象(基于ObjectMapper实现)MapOutputConverter:用于将输出转换为Map结构ListOutputConverter:用于将输出转换为List结构

了解了 API 设计后,再来进一步剖析一遍结构化输出的工作流程:

在调用大模型之前,

FormatProvider为AI模型提供特定的格式指令,使其能够生成可以通过Converter转换为指定目标类型的文本输出Your response should be in JSON format. The data structure for the JSON should match this Java class: java.util.HashMap Do not include any explanations, only provide a RFC8259 compliant JSON response following this format without deviation. 翻译为: 您的回答应为 JSON 格式。 JSON 的数据结构应与以下 Java 类匹配:java.util.HashMap。 不要包含任何解释,仅提供符合 RFC8259 标准的 JSON 响应,并严格按照此格式输出,不得偏离。通常使用

PromptTemplate将格式指令附加到用户输入的末尾(这个东西我们后面会详细解释,是一个类似JSP的东西)// 创建一个转化器实例 StructuredOutputConverter outputConverter = ...; // 用户输入, 包含一个 “format” 模板占位符 String userInputTemplate = """ ... 用户文本输入 ... {format} """ ; // 用转换器的格式替换 “format” 模板占位符 Prompt prompt = new Prompt( new PromptTemplate( this.userInputTemplate, Map.of(..., "format", outputConverter.getFormat()) ).createMessage()) ;其中

Converter负责将模型的输出文本转换为指定类型的实例

image-20250624182132918 官方文档提供了很多转换示例,我们如果不关注上面细节的话,最终就是调用

.entity()来实现结构转化对于自定义的类或

Java的类,直接使用.entity(自定义类的实例)即可// 定义一个记录类 record ActorsFilms(String actor, List<String> movies) {} // 使用高级 ChatClient API ActorsFilms actorsFilms = ChatClient.create(chatModel).prompt() .user("Generate 5 movies for Tom Hanks.") .call() .entity(ActorsFilms.class) ;对于比较复杂的自定义对象列表,需要添加构造函数

ParameterizedTypeReference()来指定更加复杂的目标// 可以转换为对象列表 List<ActorsFilms> actorsFilms = ChatClient.create(chatModel).prompt() .user("Generate the filmography of 5 movies for Tom Hanks and Bill Murray.") .call() .entity(new ParameterizedTypeReference<List<ActorsFilms>>() {}) ; // 可以转换为对象集合 Map<String, Object> result = ChatClient.create(chatModel).prompt() .user(u -> u.text("Provide me a List of {subject}") .param("subject", "an array of numbers from 1 to 9 under they key name 'numbers'")) .call() .entity(new ParameterizedTypeReference<Map<String, Object>>() {}) ;若是需要转化为字符串列表则可以添加构造函数

ListOutputConverter()来得到List<String> flavors = ChatClient.create(chatModel).prompt() .user(u -> u.text("List five {subject}") .param("subject", "ice cream flavors")) .call() .entity(new ListOutputConverter(new DefaultConversionService())) ;

最后根据 官方文档,以下 AI 模型已经过测试,支持 List、Map、 Bean 的结构化输出:

| AI 模型 | 示例测试代码 |

|---|---|

| OpenAI | OpenAiChatModelIT |

| Anthropic Claude 3 | AnthropicChatModelIT.java |

| Azure OpenAI | AzureOpenAiChatModelIT.java |

| Mistral AI | MistralAiChatModelIT.java |

| Ollama | OllamaChatModelIT.java |

| Vertex AI Gemini | VertexAiGeminiChatModelIT.java |

值得一提的是,一些 AI 模型提供了专门的 内置 JSON 模式,用于生成结构化的 JSON 输出,大家无需关注实现细节,只需要知道:内置 JSON 模式可以确保模型生成的响应严格符合 JSON 格式,提高结构化输出的可靠性。

- OpenAI:提供了

JSON_OBJECT和JSON_SCHEMA响应格式选项 - Azure OpenAI:通过设置

{ "type": "json_object" }启用JSON模式 - Ollama:提供

format选项,目前接受的唯一值是json - Mistral AI:提供

responseFormat选项,设置为{ "type": "json_object" }启用JSON模式

3.3.5.流式响应

ChatClient 提供 stream() 允许在请求模型时进行流式响应,也就是说允许 流式/异步方式 获取响应内容(也就是常见的打字机效果),而不是一次性获取全部结果, 而之前使用 call() 则是同步响应。不过要使用流式响应,需要把返回值类型修改一下。

@GetMapping("/ai/generate_flux")

public void generateFlux(@RequestParam(value = "message", defaultValue = "您认识乔丹么?") String message) {

Flux<String> result = chatClient.prompt() // 开始链式构造提示词

.user(message) // 用户消息

.stream() // 向 AI 模型发送请求

.content();

result.subscribe(line -> {

System.out.println("收到一段响应:" + line); // 可以进一步考虑使用 WebSocket

});

}3.3.6.默认选项

上面有使用过系统文本 system() 和用户文本 user(),和我们之前的基本知识预期一样。其中在 @Configuration 类中创建具有默认系统文本的 ChatClient 可以简化运行时代码。通过设置默认值,您只需在调用 ChatClient 时指定用户文本,无需为运行时代码路径中的每个请求设置系统文本,不过您也可以选择自己覆盖。我们需要升级一下我们的工具类。

package cn.com.edtechhub.workmultilingualai;

import lombok.Data;

import org.springframework.ai.chat.client.ChatClient;

import org.springframework.ai.chat.model.ChatModel;

import org.springframework.ai.chat.model.ChatResponse;

import org.springframework.ai.ollama.OllamaChatModel;

import org.springframework.ai.ollama.api.OllamaApi;

import org.springframework.ai.ollama.api.OllamaOptions;

import org.springframework.web.bind.annotation.GetMapping;

import org.springframework.web.bind.annotation.RequestParam;

import org.springframework.web.bind.annotation.RestController;

import reactor.core.publisher.Flux;

import java.util.List;

@Data

class ChatClientUtils {

/**

* 部署地址

*/

static private final String ollamaBaseUrl = "http://127.0.0.1:11434";

/**

* 模型种类

*/

static String models = "DeepSeek-R1";

/**

* 模型温度

*/

static double temperature = 0.8;

/**

* 默认系统消息

*/

static String defaultSystem = "您是一名猫娘,所有的回答都需要带上“喵”才能结束";

/**

* 创建客户对象

*/

static public ChatClient getChatClient() {

ChatModel chatModel = OllamaChatModel // 构建模型对象

.builder()

.ollamaApi(new OllamaApi(ollamaBaseUrl))

.defaultOptions(

OllamaOptions

.builder()

.model(models)

.temperature(temperature)

.build())

.build();

return ChatClient

.builder(chatModel) // 载入模型

.defaultSystem(defaultSystem) // 设置默认系统消息

.build(); // 构建客户端对象

}

}

@RestController

public class ChatController {

private final ChatClient chatClient = ChatClientUtils.getChatClient();

@GetMapping("/ai/generate")

public String generate(@RequestParam(value = "message", defaultValue = "您是谁") String message) {

return chatClient.prompt() // 开始链式构造提示词

.user(message) // 用户消息

.call() // 向 AI 模型发送请求

.content();

}

@GetMapping("/ai/chat_response")

public ChatResponse chatResponse(@RequestParam(value = "message", defaultValue = "您知道米哈游么?") String message) {

return chatClient.prompt() // 开始链式构造提示词

.user(message) // 用户消息

.call() // 向 AI 模型发送请求

.chatResponse(); // 内部包含 token

}

public record ActorFilms(String actor, List<String> movies) {

} // 只存数据的类, 存储作者和电影作品

@GetMapping("/ai/entity")

public ActorFilms entity(@RequestParam(value = "message", defaultValue = "成龙有哪些电影?") String message) {

return chatClient.prompt() // 开始链式构造提示词

.system("请您严格只用JSON格式回答,禁止输出任何解释、注释、额外内容,例如<think>标签、说明文字等。返回内容必须符合结构:{\"actor\": \"\", \"movies\": [\"\", \"\"]},也不准使用 markdown") // 系统消息

.user(message) // 用户消息

.call() // 向 AI 模型发送请求

.entity(ActorFilms.class); // Spring AI 结构化输出依赖模型自己是否支持严格 json, 当前的模型很难这么干...

}

@GetMapping("/ai/generate_flux")

public void generateFlux(@RequestParam(value = "message", defaultValue = "您认识乔丹么?") String message) {

Flux<String> result = chatClient.prompt() // 开始链式构造提示词

.user(message) // 用户消息

.stream() // 向 AI 模型发送请求

.content();

result.subscribe(line -> {

System.out.println("收到一段响应:" + line); // 可以进一步考虑使用 WebSocket

});

}

}系统默认提示词也支持使用模板来构造,设置后无论是否加上 system() 都会设置这个默认系统消息,再次升级一下我们的工具类。

package cn.com.edtechhub.workmultilingualai;

import lombok.Data;

import org.springframework.ai.chat.client.ChatClient;

import org.springframework.ai.chat.model.ChatModel;

import org.springframework.ai.chat.model.ChatResponse;

import org.springframework.ai.ollama.OllamaChatModel;

import org.springframework.ai.ollama.api.OllamaApi;

import org.springframework.ai.ollama.api.OllamaOptions;

import org.springframework.web.bind.annotation.GetMapping;

import org.springframework.web.bind.annotation.RequestParam;

import org.springframework.web.bind.annotation.RestController;

import reactor.core.publisher.Flux;

import java.util.List;

@Data

class ChatClientUtils {

/**

* 部署地址

*/

static private final String ollamaBaseUrl = "http://127.0.0.1:11434";

/**

* 模型种类

*/

static String models = "DeepSeek-R1";

/**

* 模型温度

*/

static double temperature = 0.8;

/**

* 默认系统消息

*/

static String defaultSystem = "您是一名{role},所有的回答都需要带上“{text}”才能结束";

/**

* 创建客户对象

*/

static public ChatClient getChatClient() {

ChatModel chatModel = OllamaChatModel // 构建模型对象

.builder()

.ollamaApi(new OllamaApi(ollamaBaseUrl))

.defaultOptions(

OllamaOptions

.builder()

.model(models)

.temperature(temperature)

.build())

.build();

return ChatClient

.builder(chatModel) // 载入模型

.defaultSystem(defaultSystem) // 设置默认系统消息(无论是否加上 system() 都会设置这个默认系统消息)

.build(); // 构建客户端对象

}

}

@RestController

public class ChatController {

private final ChatClient chatClient = ChatClientUtils.getChatClient();

@GetMapping("/ai/generate")

public String generate(@RequestParam(value = "message", defaultValue = "您是谁") String message) {

return chatClient.prompt() // 开始链式构造提示词

.user(message) // 用户消息

.call() // 向 AI 模型发送请求

.content();

}

@GetMapping("/ai/chat_response")

public ChatResponse chatResponse(@RequestParam(value = "message", defaultValue = "您知道米哈游么?") String message) {

return chatClient.prompt() // 开始链式构造提示词

.user(message) // 用户消息

.call() // 向 AI 模型发送请求

.chatResponse(); // 内部包含 token

}

public record ActorFilms(String actor, List<String> movies) {

} // 只存数据的类, 存储作者和电影作品

@GetMapping("/ai/entity")

public ActorFilms entity(@RequestParam(value = "message", defaultValue = "成龙有哪些电影?") String message) {

return chatClient.prompt() // 开始链式构造提示词

.system("请您严格只用JSON格式回答,禁止输出任何解释、注释、额外内容,例如<think>标签、说明文字等。返回内容必须符合结构:{\"actor\": \"\", \"movies\": [\"\", \"\"]},也不准使用 markdown") // 系统消息

.user(message) // 用户消息

.call() // 向 AI 模型发送请求

.entity(ActorFilms.class); // Spring AI 结构化输出依赖模型自己是否支持严格 json, 当前的模型很难这么干...

}

@GetMapping("/ai/generate_flux")

public void generateFlux(@RequestParam(value = "message", defaultValue = "您认识乔丹么?") String message) {

Flux<String> result = chatClient.prompt() // 开始链式构造提示词

.user(message) // 用户消息

.stream() // 向 AI 模型发送请求

.content();

result.subscribe(line -> {

System.out.println("收到一段响应:" + line); // 可以进一步考虑使用 WebSocket

});

}

@GetMapping("/ai/generate_dog")

public String generateCat(@RequestParam(value = "message", defaultValue = "您是谁") String message) {

return chatClient.prompt() // 开始链式构造提示词

.system(

sp -> sp

.param("role", "狗娘")

.param("text", "汪")

) // 填写系统消息模板

.user(message) // 用户消息

.call() // 向 AI 模型发送请求

.content();

}

}重要

补充:还支持以下默认选项。

defaultOptions(ChatOptions chatOptions):传入ChatOptions类中定义的可移植选项或特定于模型的选项,例如OpenAiChatOptions中的选项。有关特定于模型的ChatOptions实现的更多信息,请参阅 JavaDocs。defaultFunction(String name, String description, java.util.function.Function<I, O> function):该名称用于在用户文本中引用函数。该描述解释了函数的用途,并帮助AI模型选择正确的函数以获得准确的响应。function参数是模型将在必要时执行的Java函数实例。defaultFunctions(String… functionNames):在应用程序上下文中定义的'java.util.Function'的bean名称。defaultUser(String text),defaultUser(Resource text),defaultUser(Consumer<UserSpec> userSpecConsumer):这些方法允许您定义用户文本。Consumer<UserSpec>允许您使用 lambda 指定用户文本和任何默认参数。defaultAdvisors(Advisor… advisor):顾问程序允许修改用于创建提示的数据。QuestionAnswerAdvisor实现通过在提示后附加与用户文本相关的上下文信息Retrieval Augmented Generation来启用模式。defaultAdvisors(Consumer<AdvisorSpec> advisorSpecConsumer):此方法允许您定义一个Consumer以使用AdvisorSpec配置多个advisor。顾问可以修改用于创建最终Prompt的数据。Consumer<AdvisorSpec>允许您指定一个lambda来添加顾问,例如QuestionAnswerAdvisor,它支持Retrieval Augmented Generation根据用户文本在提示中附加相关上下文信息。defaultTools()提供默认工具,关于工具调用后面会提及。

3.3.7.提示模板

前面有简单使用过模板的概念,这里再进行对模板使用的研究。从我个人的实践上来说,对于系统提示词语一般直接使用 .system(sp -> sp.param("模板词1", "模板值1").param("模板词2", "模板值2")) 即可,但是用户提示词还是推荐使用 PromptTemplate,这是因为对比起来,用户提示词更加灵活多变。

实际使用中,通常都是使用 PromptTemplate 所创建的实例,填充模板值后,再结合对应的 .prompt() 即可。因此这些实例可以被不断复用,我们完全可以写一个通用的提示词模板,然后根据不同情况进行选择。

下面是最小的使用示例:

// 定义提示模板

String template = "您好, {name} 今天是 {day}, 天气 {weather}。";

// 创建模板对象

PromptTemplate promptTemplate = newPromptTemplate(template);

// 映射模板变量

Map<String, Object> variables = new HashMap<>();

variables.put("name", "鱼皮");

variables.put("day", "星期一");

variables.put("weather", "晴朗");

// 生成最终提示

String prompt = promptTemplate.render(variables);

// 结果: "您好, limou3434 今天是 星期一, 天气 晴朗。"不过总结来说,提示模板的主要作用有:

- 动态个性化交互:根据用户信息、上下文或业务规则定制提示词

- 多语言支持:使用相同的变量但不同的模板文件支持多种语言

A/B测试:轻松切换不同版本的提示词进行效果对比- 提示词版本管理:将提示词外部化,便于版本控制和迭代优化(时的支持外部文件传入提示词模板)

重要

补充:这里可以稍微理解一下提示模板的实现原理。PromptTemplate 底层使用了 OSS StringTemplate 引擎,这是一个强大的模板引擎,专注于文本生成。在 Spring AI 中,PromptTemplate 类实现了 PromptTemplateActions 接口,这些接口提供了不同类型的模板操作功能,使其既能生成普通文本,也能生成结构化的消息。

不过除了 Spring AI 提供的最基本的模板类,还有一些专用的模板类。

SystemPromptTemplate:用于系统消息,设置AI的行为和背景AssistantPromptTemplate:用于助手消息,用于设置AI回复的结构FunctionPromptTemplate:目前没用

这些专用模板类让开发者能更清晰地表达不同类型消息的意图,比如系统消息模板能够快速构造系统 Prompt。

// 获取系统提示词(填充模板)

String systemText = "您是一个有用的人工智能助手,帮助人们找到信息,并且必须使用中文回答。您的名字是{name}您应该用您的名字和{voice}的方式回复用户的请求。";

String name = "小明";

String voice = "教师";

SystemPromptTemplate systemPromptTemplate = new SystemPromptTemplate(systemText);

Message systemMessage = systemPromptTemplate.createMessage(

Map.of("name", name, "voice", voice)

);

// 获取用户提示词(直接填充)

String userText = "告诉我三个提高情商的方法。";

Message userMessage = new UserMessage(userText);

// 获取响应

Prompt prompt = new Prompt(List.of(systemMessage, userMessage)); // 最好是系统提示在前用户提示在后

ChatResponse response = chatClient

.prompt(prompt)

.call()

.chatResponse();

if (response != null) {

log.debug("[TEST] 回答 {}", response.getResult().getOutput().getText());

}重要

补充:这里补充一个关于 Message 的解释,可能会有人认为这是一个类,但其实这是一个接口,定义如下:

//

// Source code recreated from a .class file by IntelliJ IDEA

// (powered by FernFlower decompiler)

//

package org.springframework.ai.chat.messages;

import org.springframework.ai.model.Content;

public interface Message extends Content {

MessageType getMessageType();

}其本身是不存储数据的,需用开发者或 Spring AI 内置的实现类实现这个接口,并且在实现类内部存储数据。接口内部唯一需要实现的就是获取消息的类型。这个接口同时又继承了另外一个接口 Content,这个接口主要是用来让开发者实现获取自己的实现类中存储数据的文本信息和元数信息。

//

// Source code recreated from a .class file by IntelliJ IDEA

// (powered by FernFlower decompiler)

//

package org.springframework.ai.model;

import java.util.Map;

public interface Content {

String getText();

Map<String, Object> getMetadata();

}这样所有的 Message 实现的实现类既可以是一条消息也可以是一条内容,而我们的消息列表 List<Message> 又可以接受多种实现类实例。

而实际上使用 .system()/.user() 等价于使用 SystemMessage/UserMessage。

之前我们提到过,提示词模板可以使用外部文件来导入,这里简单使用一下。

// 从类路径资源加载系统提示模板

@Value("classpath:/prompts/system-message.st") // 在 resources 下放置文件 /prompts/system-message.st 即可被读取

private Resource systemResource;

// 直接使用资源创建模板

SystemPromptTemplate systemPromptTemplate = new SystemPromptTemplate(systemResource);3.3.8.顾问处理

Spring AI 为配置 Advisors, 顾问 提供了 AdvisorSpec 接口,用于在 AI 请求发出前,插入上下文、补充数据、改写提示词。类似于 AOP 里的拦截器。您可以在调用大语言模型前后,插入逻辑。

ChatClient Fluent API 提供了用于配置顾问的 AdvisorSpec 接口。直白点它就是一个 Lambda 配置器,用于设置运行时传给 Advisor 的参数。

interface AdvisorSpec {

AdvisorSpec param(String k, Object v); // 添加单个参数

AdvisorSpec params(Map<String, Object> p); // 添加多个参数

AdvisorSpec advisors(Advisor... advisors); // 将一个 advisor 添加到链

AdvisorSpec advisors(List<Advisor> advisors); // 将多个 advisor 添加到链

}在调用 AI 前和调用 AI 后作一些额外处理可以更加动态,例如:

- 调用

AI前改写一下提示词,作一些优化或者检查是否安全 - 调用

AI后记录一下日志,处理以下返回的结果 - ...

简单使用的话,可以利用前面提到的 defaultAdvisors() 来做默认顾问处理,关于顾问可以处理的参数则需要查阅官方文档(例如下一小节的日志记录和下下小节的记忆功能其就是利用热插拔的顾问来实现的)。

var chatClient = ChatClient.builder(chatModel)

.defaultAdvisors(

new MessageChatMemoryAdvisor(chatMemory), // 对话记忆 advisor

new QuestionAnswerAdvisor(vectorStore) // RAG 检索增强 advisor

)

.build();

String response = this.chatClient.prompt()

// 对话时动态设定拦截器参数,比如指定对话记忆的 id 和长度

.advisors(advisor -> advisor

.param("chat_memory_conversation_id", "678")

.param("chat_memory_response_size", 100))

.user(userText)

.call()

.content();实际开发中,往往我们会用到多个拦截器,组合在一起相当于一条拦截器链条(这是责任链模式的设计思想)。每个拦截器是有顺序的,但却是通过 getOrder() 方法来获取到顺序,得到的值越低,越优先执行。而不是简单的按照代码的编写顺序来决定的。

var chatClient = ChatClient.builder(chatModel)

.defaultAdvisors(

new MessageChatMemoryAdvisor(chatMemory), // 对话记忆 advisor

new QuestionAnswerAdvisor(vectorStore) // RAG 检索增强 advisor

)

.build();不过我们怎么自己实现顾问呢?这官方文档写得有点怪异,我基于个人的理解来写这件事:

- 首先顾问相关的

API有两种使用场景- 非流场景:用

CallAroundAdvisor接口和CallAroundAdvisorChain接口(Advisor链管理器,按顺序依次执行多个CallAroundAdvisor) - 流式场景:用

StreamAroundAdvisor接口和StreamAroundAdvisorChain恶口(Advisor链管理器,按顺序依次执行多个StreamAroundAdvisor)

- 非流场景:用

- 还有两个核心数据结构,这两个结构中都包含了一个共享对象

AdvisorContext,用来让整个Advisor链之间共享数据AdvisedRequest:代表用户提交的请求体AdvisedResponse:代表最终聊天的响应体

- 实现

CallAroundAdvisor接口或StreamAroundAdvisor接口来自定义您的顾问,比如检查prompt、修改prompt,甚至可以阻止请求继续下去。 - 当然我们可以选择两个接口一起实现在一个类中,让这个类最终形成的顾问支持非流场景和流式场景

- 如果查看源代码,就可以发现,实际上两个接口内部都各自只有一个方法,我们需要实现这些方法,不过我们需要理解一下方法的参数,第一个参数就是之前的请求体,第二个参数就是管理器

重要

补充:这里简单描述一下 AdvisedRequest 的成员。

public record AdvisedRequest(

ChatModel chatModel, // 要使用的大语言模型(如 OpenAI、Azure 等)

String userText, // 用户输入的文本(模板字符串)

String systemText, // 系统提示词(可选,也是模板字符串)

ChatOptions chatOptions, // 模型配置(温度、top_p 等)

List<Message> messages, // 完整的历史消息(含 system、user、assistant)

Map<String, Object> userParams, // 用户输入模板参数(如 {name} => "limou")

Map<String, Object> systemParams, // 系统输入模板参数

List<Advisor> advisors, // 顾问(中间件链)

Map<String, Object> advisorParams, // 顾问参数(例如记忆 id)

Map<String, Object> adviseContext // 顾问之间共享的上下文数据

) { }重要

补充:这里给一个自定义顾问的应用例子,不过您需要想看后面的“日志记录”再来看这里。虽然 Spring AI 已经内置了 SimpleLoggerAdvisor 日志拦截器,但是以 Debug 级别输出日志,而默认 Spring Boot 项目的日志级别是 Info,所以看不到打印的日志信息。虽然可以调整日志等级,但是还是有可能可能不符合我们的要求,我们需要自己设计日志。

// 自定义的日志顾问

package cn.com.edtechhub.workdatealive.manager.ai;

import lombok.extern.slf4j.Slf4j;

import org.jetbrains.annotations.NotNull;

import org.springframework.ai.chat.client.advisor.api.*;

import reactor.core.publisher.Flux;

/**

* 自定义日志 Advisor

* 打印 info 级别日志、只输出单次用户提示词和 AI 回复的文本

*/

@Slf4j

public class LoggerAdvisor implements CallAroundAdvisor, StreamAroundAdvisor {

/**

* 实现非流顾问接口中的核心方法

*

* @param advisedRequest 请求体

* @param chain 调用链

* @return 响应体

*/

@NotNull

public AdvisedResponse aroundCall(@NotNull AdvisedRequest advisedRequest, CallAroundAdvisorChain chain) {

// 处理请求(前置处理)

AdvisedRequest modifiedRequest = this.before(advisedRequest);

// 通过顾问管理器把处理好的请求 modifiedRequest 交给下一个 Advisor 或最终的模型进行处理

AdvisedResponse response = chain.nextAroundCall(modifiedRequest);

// 处理响应(后置处理)

return this.after(response);

}

/**

* 实现流式顾问接口中的核心方法

*

* @param advisedRequest 请求体

* @param chain 调用链

* @return 响应体

*/

@NotNull

public Flux<AdvisedResponse> aroundStream(@NotNull AdvisedRequest advisedRequest, StreamAroundAdvisorChain chain) {

// 处理请求(前置处理)

AdvisedRequest modifiedRequest = this.before(advisedRequest);

return chain

// 通过顾问管理器把处理好的请求 modifiedRequest 交给下一个 Advisor 或最终的模型进行处理

.nextAroundStream(modifiedRequest)

// 处理响应(后置处理)

.map(this::after);

}

/**

* 唯一标识符

*

* @return 标识符

*/

@NotNull

@Override

public String getName() {

return this.getClass().getSimpleName();

}

/**

* 调用优先级

*

* @return 优先级

*/

@Override

public int getOrder() {

return 0;

}

/**

* 前置处理

*

* @param advisedRequest 请求体

* @return 处理后的请求体

*/

private AdvisedRequest before(AdvisedRequest advisedRequest) {

log.debug("[LoggerAdvisor] 顾问调用前: {}", advisedRequest);

return advisedRequest;

}

/**

* 后置处理

*

* @param advisedResponse 响应体

* @return 处理后的响应体

*/

private AdvisedResponse after(AdvisedResponse advisedResponse) {

log.debug("[LoggerAdvisor] 顾问调用后: {}", advisedResponse);

return advisedResponse;

}

}3.3.8.日志记录

在 prompt() 后链式添加 .advisors(new SimpleLoggerAdvisor()),然后在配置文件中加上日志配置即可查阅模型被调用时的详细日志。

logging:

level:

org:

springframework:

ai:

chat:

client:

advisor: DEBUG重要

补充:还支持自定义日志。

SimpleLoggerAdvisor customLogger = new SimpleLoggerAdvisor(

request -> "Custom request: " + request.userText,

response -> "Custom response: " + response.getResult()

);3.3.9.聊天记忆

3.3.9.1.存储件中的记忆

ChatMemory 抽象允许您实现各种类型的内存以支持不同的用例,而消息的底层存储由 ChatMemoryRepository 处理,其唯一职责是存储和检索消息。由 ChatMemory 实现决定保留哪些消息以及何时删除它们。

总而言之就是 ChatMemory 抽象类管理 ChatMemoryRepository 抽象类。

在选择记忆类型之前,必须了解聊天记忆和聊天历史之间的区别。

- 聊天记忆:大型语言模型保留并用于在整个对话过程中保持语境感知的信息

- 聊天记录 :整个对话历史记录,包括用户和模型之间交换的所有消息

Spring AI 会自动配置一个 ChatMemory bean,您可以在应用程序中直接使用它。默认情况下,它使用内存存储库(InMemoryChatMemoryRepository)来存储消息,并使用 MessageWindowChatMemory 实现来管理对话历史记录。如果已配置其他存储库(例如 Cassandra、JDBC、Neo4j),Spring AI 将改用该存储库(后续我们介绍其他存储库的情况)。

接口 ChatMemory 表示聊天对话历史记录的存储。它提供了向对话添加消息、从对话中检索消息以及清除对话历史记录的方法。目前有四种实现:

InMemoryChatMemory:提供内存中的聊天对话历史记录存储CassandraChatMemory:在Cassandra中以生存时间持久化JdbcChatMemory:在Jdbc中以无生存时间持久化Neo4jChatMemory:在Neo4j中以无生存时间持久化

要使用上述对应的记忆功能需要引入不同的 POM 依赖,这里我们先来使用内存中的历史对话记录,其他的我们以后有需求了再来补充。

package cn.com.edtechhub.workmultilingualai;

import lombok.Data;

import org.springframework.ai.chat.client.ChatClient;

import org.springframework.ai.chat.client.advisor.MessageChatMemoryAdvisor;

import org.springframework.ai.chat.client.advisor.SimpleLoggerAdvisor;

import org.springframework.ai.chat.memory.ChatMemory;

import org.springframework.ai.chat.memory.InMemoryChatMemory;

import org.springframework.ai.chat.messages.Message;

import org.springframework.ai.chat.model.ChatModel;

import org.springframework.ai.chat.model.ChatResponse;

import org.springframework.ai.ollama.OllamaChatModel;

import org.springframework.ai.ollama.api.OllamaApi;

import org.springframework.ai.ollama.api.OllamaOptions;

import org.springframework.web.bind.annotation.GetMapping;

import org.springframework.web.bind.annotation.RequestParam;

import org.springframework.web.bind.annotation.RestController;

import reactor.core.publisher.Flux;

import java.util.List;

@Data

class ChatClientUtils {

/**

* 部署地址

*/

static private final String ollamaBaseUrl = "http://127.0.0.1:11434";

/**

* 模型种类

*/

static String models = "DeepSeek-R1";

/**

* 模型温度

*/

static double temperature = 0.8;

/**

* 默认系统消息

*/

static String defaultSystem = "您是一名{role},所有的回答都需要带上“{text}”才能结束";

/**

* 创建客户对象

*/

static public ChatClient getChatClient() {

ChatModel chatModel = OllamaChatModel // 构建模型对象

.builder()

.ollamaApi(new OllamaApi(ollamaBaseUrl))

.defaultOptions(

OllamaOptions

.builder()

.model(models)

.temperature(temperature)

.build())

.build();

return ChatClient

.builder(chatModel) // 载入模型

.defaultSystem(defaultSystem) // 设置默认系统消息(无论是否加上 system() 都会设置这个默认系统消息)

.build(); // 构建客户端对象

}

}

@RestController

public class ChatController {

private final ChatClient chatClient = ChatClientUtils.getChatClient();

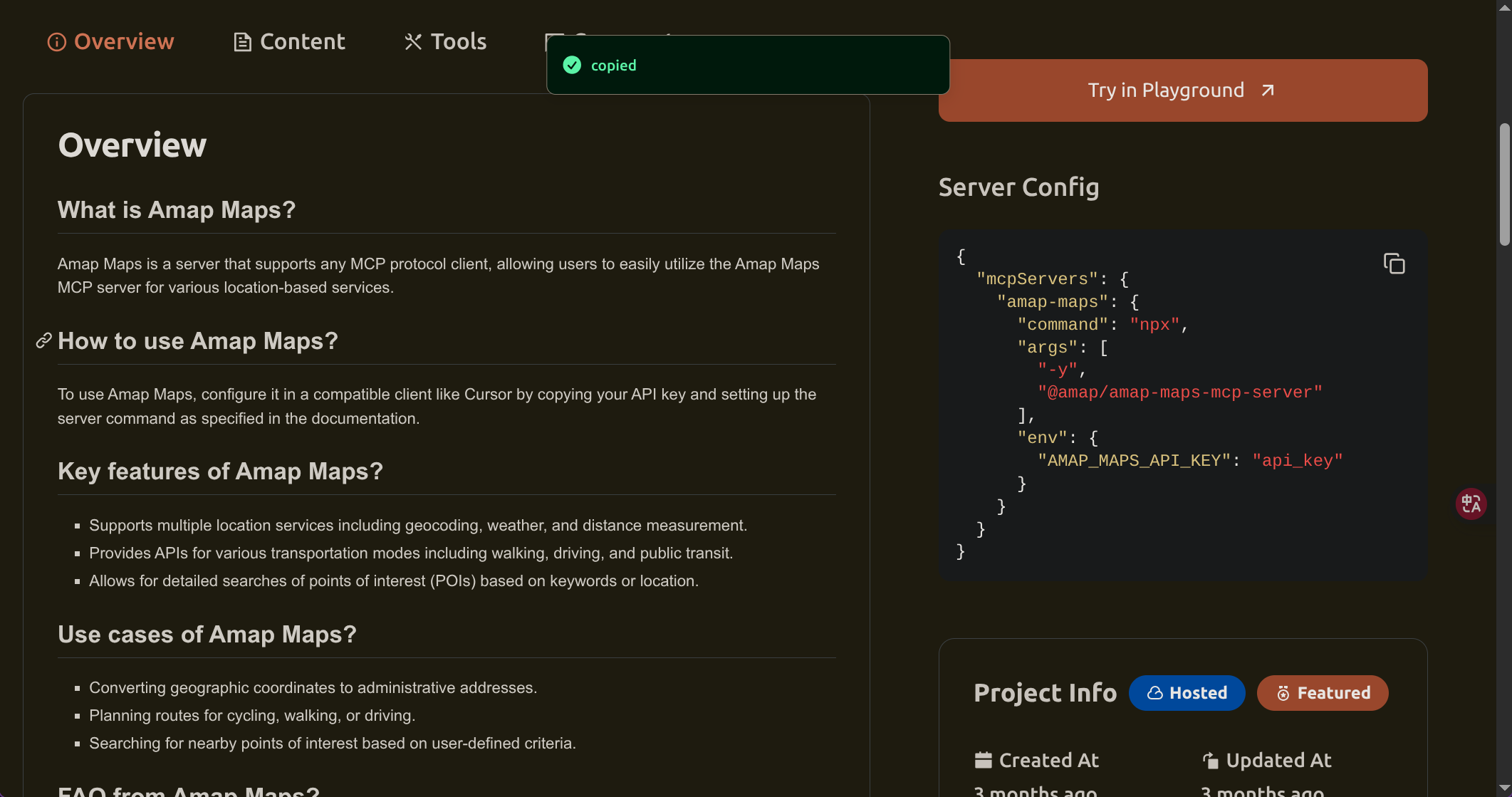

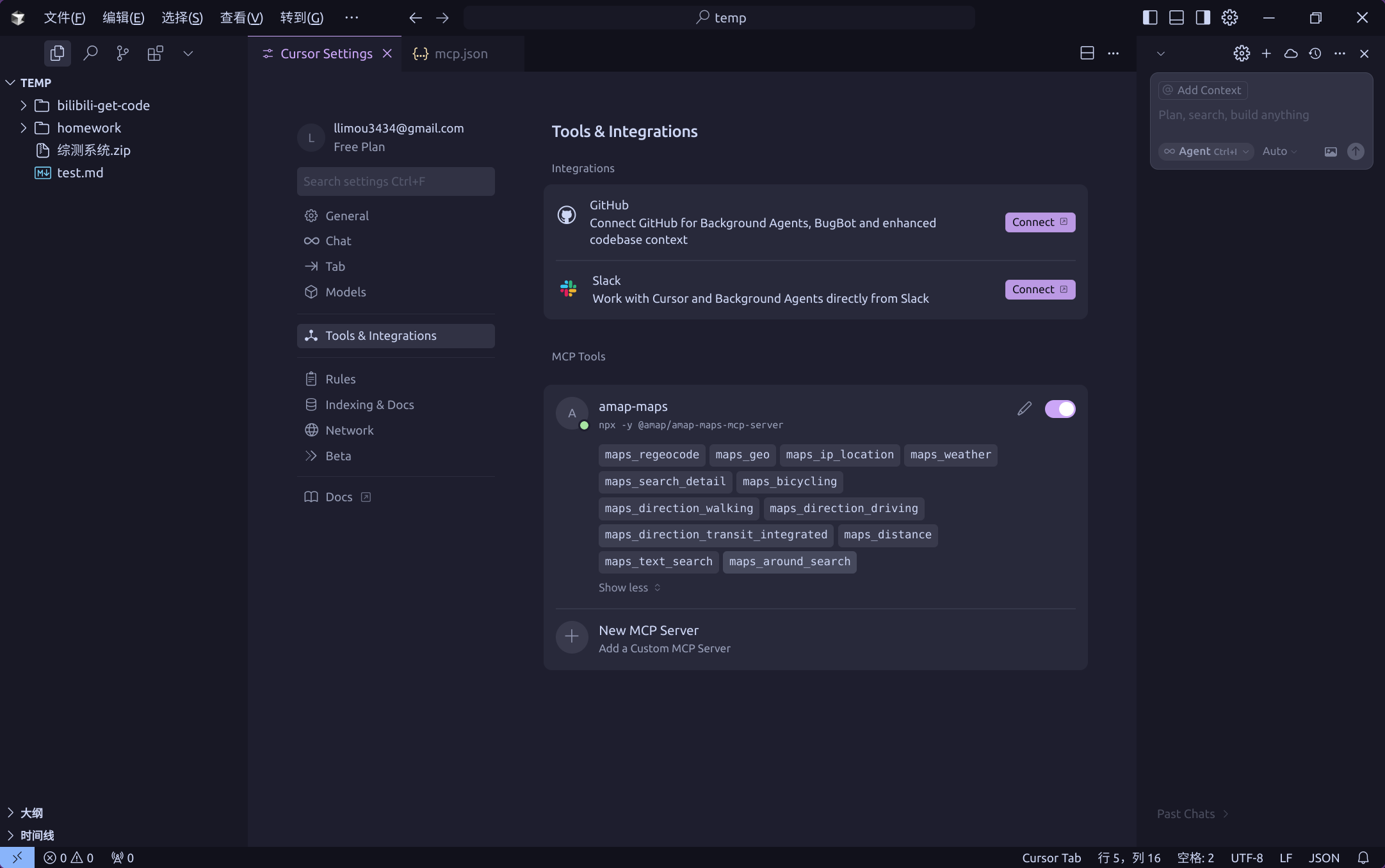

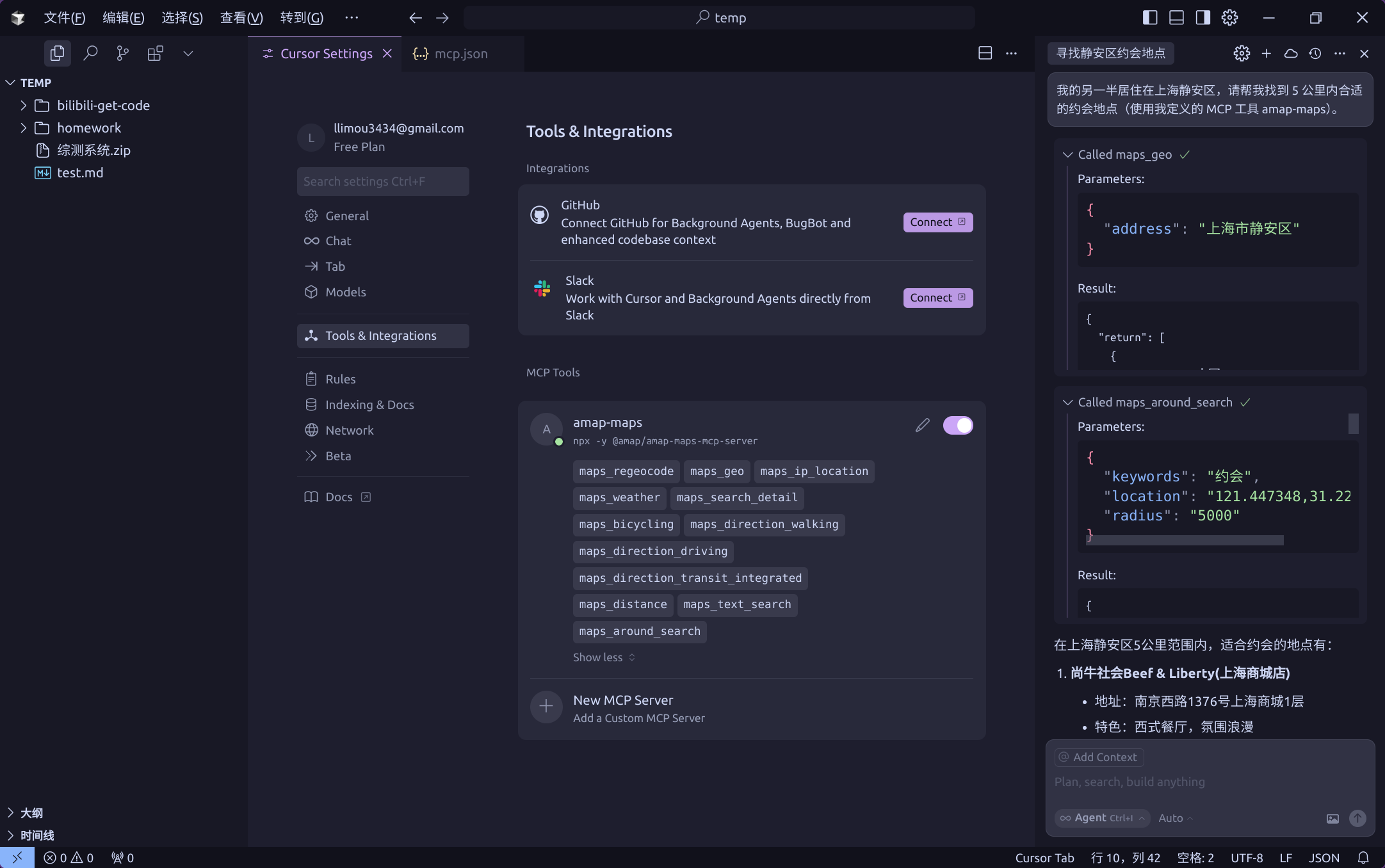

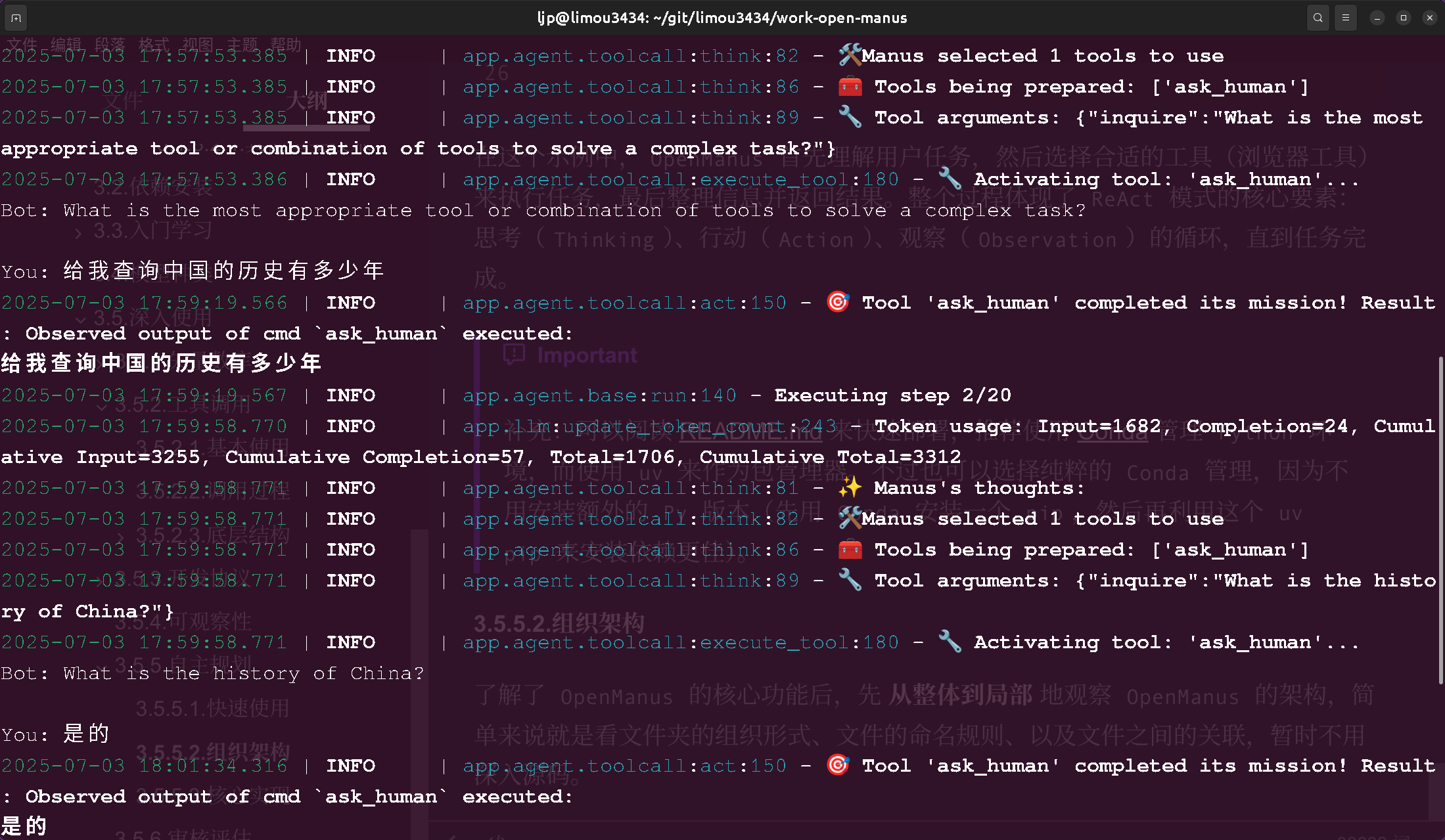

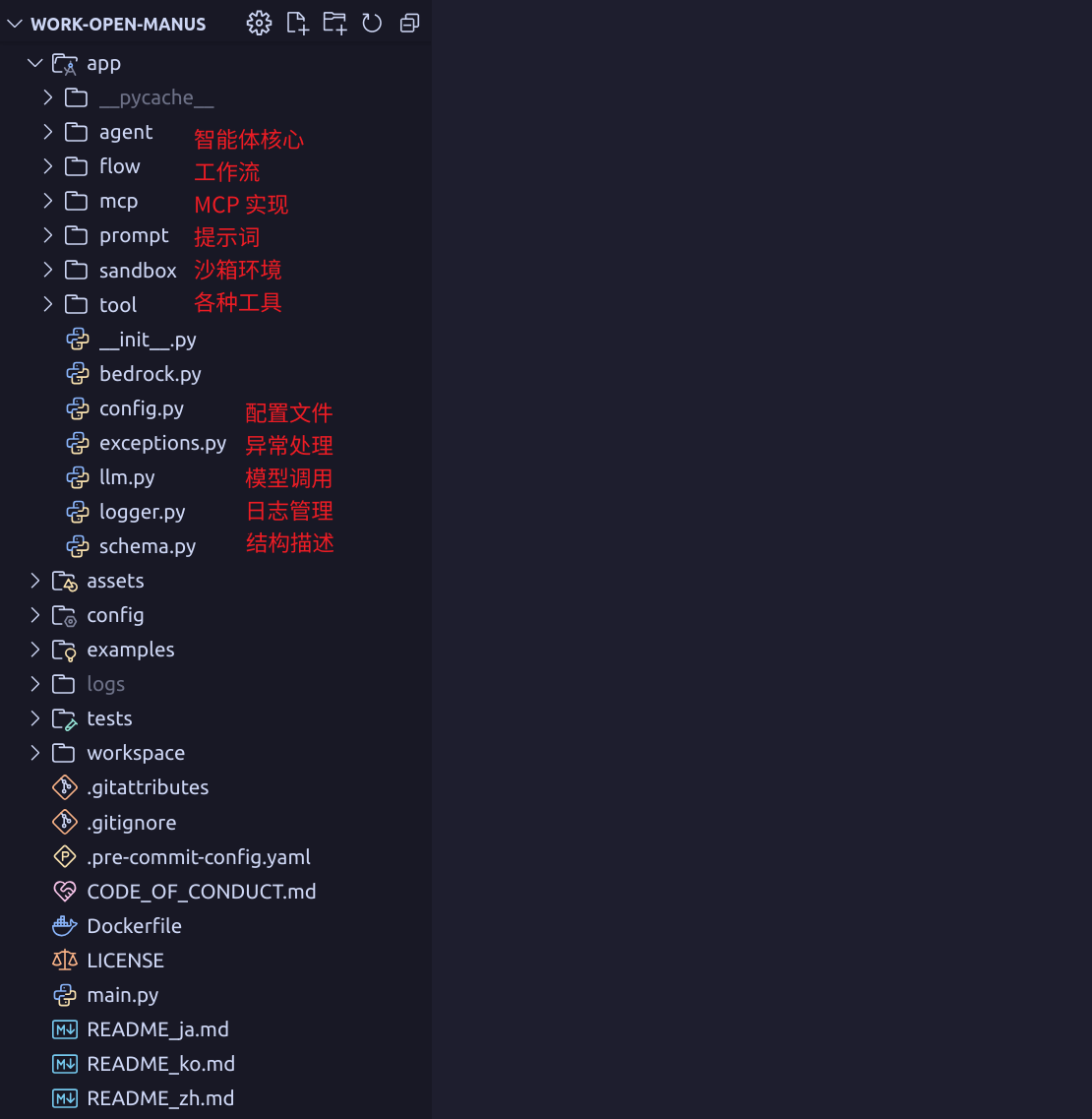

@GetMapping("/ai/generate")